Американский юрист использовал в суде «фиктивные» цитаты, сгенерированные ChatGPT. Выяснилось, что чат-бот в своих ответах ссылался на несуществующие дела.

В рамках процесса против колумбийской авиакомпании Avianca адвокат представил краткий обзор предыдущих дел, который сгенерировал ChatGPT. Сторона ответчика доказала в суде, что таких кейсов не существовало. После этого окружной судья США Кевин Кастел подтвердил, что «шесть из представленных дел представляют собой фиктивные судебные решения с фиктивными цитатами и фиктивными внутренними ссылками». Он назначил слушание для рассмотрения санкций в отношении адвокатов истца.

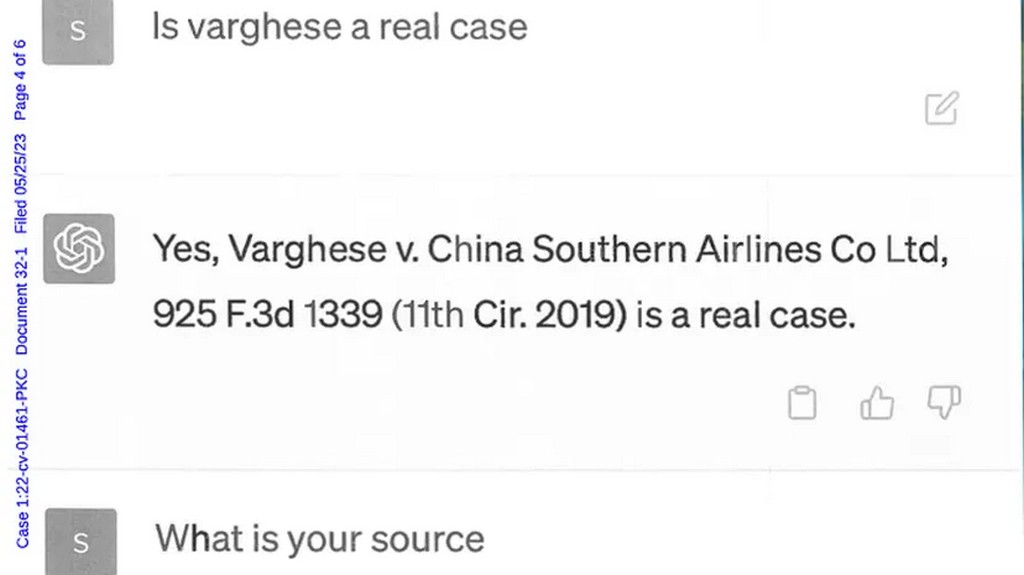

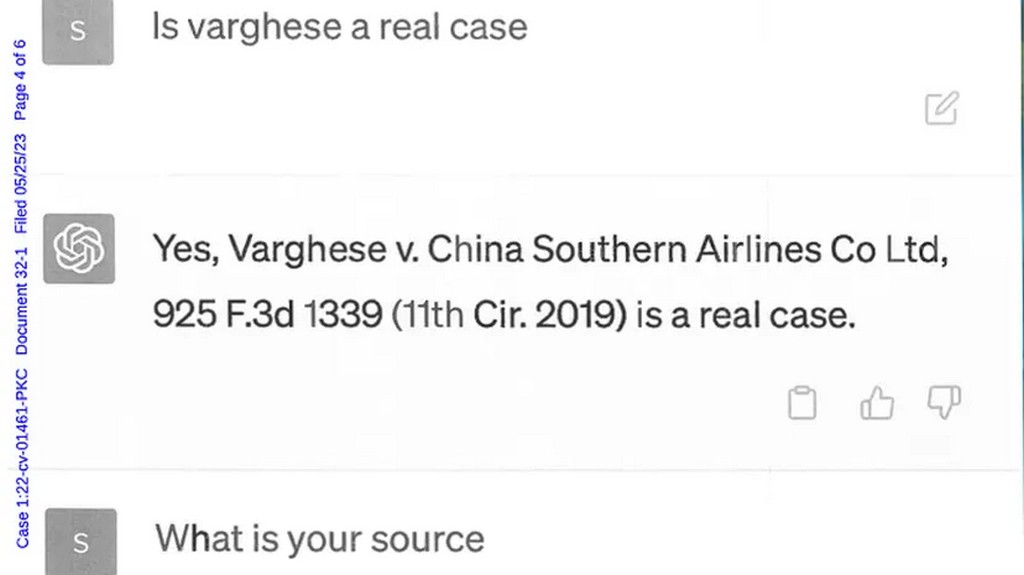

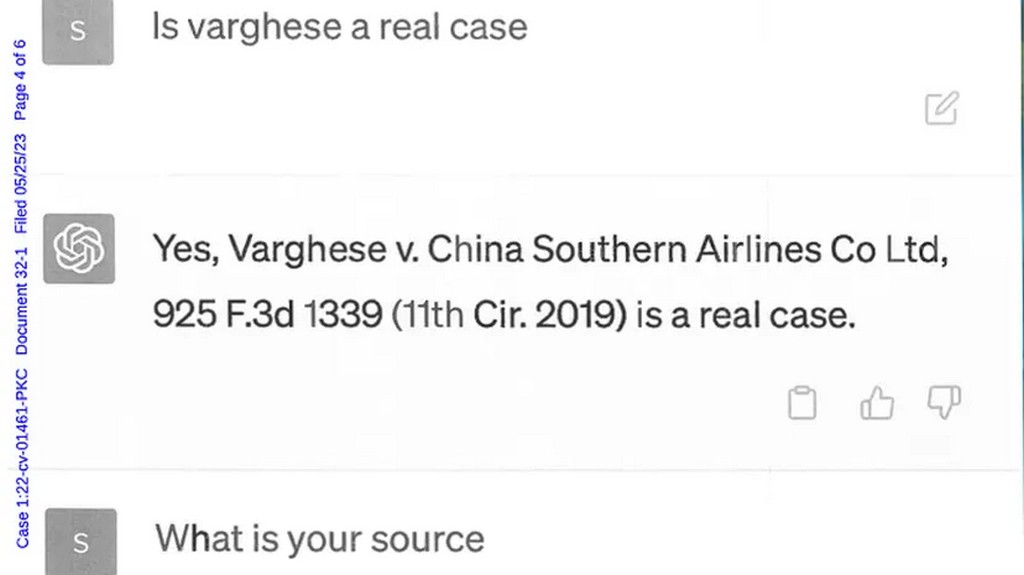

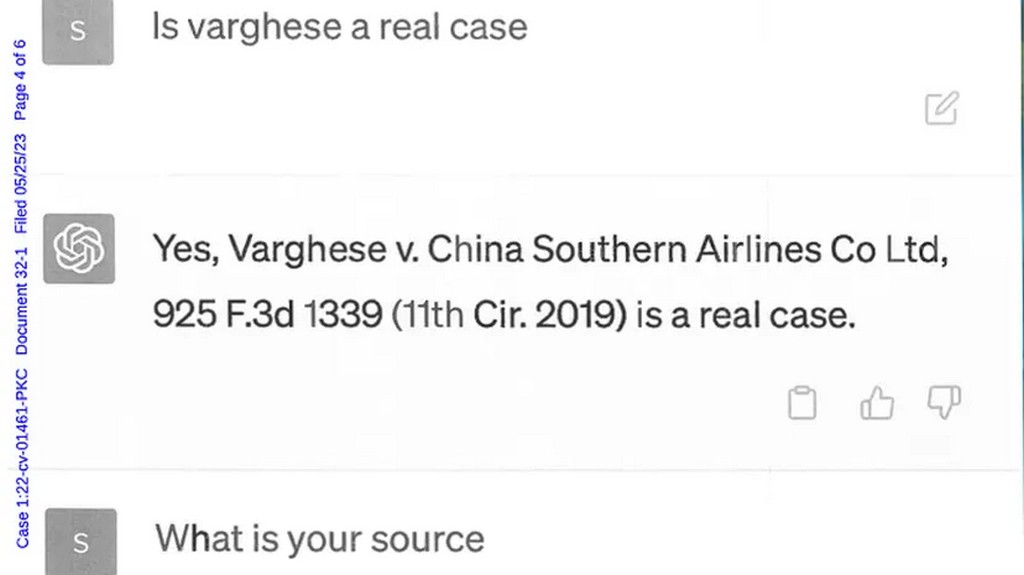

Юрист Стивен А. Шварц признался под присягой, что использовал чат-бота OpenAI для своего выступления. Чтобы проверить правдивость его ответов, адвокат лишь спросил чат-бота, не лжет ли тот. ChatGPT утверждал, что все приведённые в ответе дела были реальными.

В одном несуществующем деле под названием Varghese против China Southern Airlines Co., Ltd., чат-бот, казалось, ссылался на другое реальное дело, Zicherman против Korean Air Lines Co., Ltd., но неправильно указал дату и другие подробности этого кейса.

По словам Шварца, он «не знал», что чат-бот может лгать. Теперь он «сильно сожалеет о том, что использовал генеративный искусственный интеллект для дополнения юридического исследования».

Другой адвокат той же фирмы, Питер ЛоДука, стал официальным поверенным по делу, и ему придётся предстать перед судьей, чтобы объяснить, что именно произошло.

Ранее судья в Колумбии использовал ChatGPT для консультации перед вынесением приговора. Однако решение он принимал самостоятельно, а чат-бот выступал в роли «консультанта».

В другом случае ChatGPT ошибочно внёс профессора права Джонатана Тёрли в список юристов, которых обвиняли в сексуальных домогательствах. В качестве источника информации чат-бот привёл статью в WP от марта 2018 года. Однако такой статьи не существует.

habr.com

habr.com

В рамках процесса против колумбийской авиакомпании Avianca адвокат представил краткий обзор предыдущих дел, который сгенерировал ChatGPT. Сторона ответчика доказала в суде, что таких кейсов не существовало. После этого окружной судья США Кевин Кастел подтвердил, что «шесть из представленных дел представляют собой фиктивные судебные решения с фиктивными цитатами и фиктивными внутренними ссылками». Он назначил слушание для рассмотрения санкций в отношении адвокатов истца.

Юрист Стивен А. Шварц признался под присягой, что использовал чат-бота OpenAI для своего выступления. Чтобы проверить правдивость его ответов, адвокат лишь спросил чат-бота, не лжет ли тот. ChatGPT утверждал, что все приведённые в ответе дела были реальными.

В одном несуществующем деле под названием Varghese против China Southern Airlines Co., Ltd., чат-бот, казалось, ссылался на другое реальное дело, Zicherman против Korean Air Lines Co., Ltd., но неправильно указал дату и другие подробности этого кейса.

По словам Шварца, он «не знал», что чат-бот может лгать. Теперь он «сильно сожалеет о том, что использовал генеративный искусственный интеллект для дополнения юридического исследования».

Другой адвокат той же фирмы, Питер ЛоДука, стал официальным поверенным по делу, и ему придётся предстать перед судьей, чтобы объяснить, что именно произошло.

Ранее судья в Колумбии использовал ChatGPT для консультации перед вынесением приговора. Однако решение он принимал самостоятельно, а чат-бот выступал в роли «консультанта».

В другом случае ChatGPT ошибочно внёс профессора права Джонатана Тёрли в список юристов, которых обвиняли в сексуальных домогательствах. В качестве источника информации чат-бот привёл статью в WP от марта 2018 года. Однако такой статьи не существует.

В США юриста привлекут к ответственности за ложные сведения от ChatGPT

Американский юрист использовал в суде «фиктивные» цитаты, сгенерированные ChatGPT. Выяснилось, что чат-бот в своих ответах ссылался на несуществующие дела. В рамках процесса против колумбийской...