Данная статья рассматривает необходимые и достаточные действия для запуска и настройки RAC 21.3 в кластере kubernetes 1.26. Прецедентов на апрель 2023 г. работы вне Oracle Cloud не найдено, поэтому пришлось провести тысячи экспериментов, отбросить и принять множество гипотез.

На сегодня первая в мире выкатка RAC в kubernetes и без docker.

uname -a

Linux r02 5.4.17-2136.300.7.el8uek.x86_64 #2 SMP Fri Oct 8 16:23:01 PDT 2021 x86_64 x86_64 x86_64 GNU/Linux

OEL 8.5 уже сертифицирована для Oracle RAC, 7.9 можно не устанавливать.

containerd --version

containerd github.com/containerd/containerd v1.6.4 212e8b6fa2f44b9c21b2798135fc6fb7c53efc16

runc --version

runc version 1.0.2

spec: 1.0.2-dev

go: go1.16.7

libseccomp: 2.5.1

Основные задачи настройки выкатки RAC:

statefulset.yaml

################################################################################

# #

# Author: Serguei Nastassi itoracle@icloud.com #

# Created 01/03/2023 #

################################################################################

---

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: oracle-rac-213

spec:

serviceName: rdbms

podManagementPolicy: Parallel

updateStrategy:

type: RollingUpdate

replicas: 1

selector:

matchLabels:

app: oracle-rac-213

template:

metadata:

labels:

app: oracle-rac-213

annotations:

k8s.v1.cni.cncf.io/networks: '[

{

"name": "macvlan-conf",

"ips": ["172.16.1.150/24"]

},

{

"name": "macvlan-priv-conf",

"ips": ["192.168.17.150/24"]

}

]'

spec:

terminationGracePeriodSeconds: 300

securityContext:

sysctls:

- name: kernel.shmall

value: "2097152"

- name: kernel.sem

value: "250 32000 100 128"

- name: kernel.shmmax

value: "8589934592"

- name: kernel.shmmni

value: "4096"

containers:

- name: rdbms

image: cr.local:32424/container-registry.oracle.com/database/rac:21.3.0.0

resources:

requests:

memory: "16Gi"

limits:

memory: "16Gi"

securityContext:

privileged: true

capabilities:

add: ["SYS_NICE","SYS_RESOURCE","NET_ADMIN","AUDIT_CONTROL","AUDIT_WRITE","SYSLOG","SYS_TIME","SYS_RESOURCE","SYS_RAWIO","SYS_MODULE","SYS_CHROOT","SYS_BOOT","SYS_ADMIN","SETUID","SETGID","NET_BIND_SERVICE","CHOWN"]

runAsUser: 0

procMount: "Unmasked"

allowPrivilegeEscalation: true

envFrom:

- configMapRef:

name: oracle-rdbms-config

ports:

- containerPort: 1521

name: oracle-listener

- containerPort: 5500

name: oem-express

volumeDevices:

- name: ora-blk0

devicePath: /dev/asm_disk01

- name: ora-blk1

devicePath: /dev/asm_disk02

- name: ora-blk2

devicePath: /dev/asm_disk03

- name: ora-blk3

devicePath: /dev/asm_disk04

- name: ora-blk4

devicePath: /dev/asm_disk05

volumeMounts:

- name: oradata

mountPath: /oradata

- name: tmpfs

mountPath: /dev/shm

- name: hp

mountPath: /dev/hugepages

- name: cgroups

mountPath: /sys/fs/cgroup

# readOnly: true

- name: proc

mountPath: /hostproc

- name: boot

mountPath: /boot

readOnly: true

volumes:

- name: oradata

nfs:

server: "192.168.1.4"

path: /home/oracle-rac-213

- name: ora-blk0

persistentVolumeClaim:

claimName: nas-0-oracle-rac-213-0

- name: ora-blk1

persistentVolumeClaim:

claimName: nas-1-oracle-rac-213-0

- name: ora-blk2

persistentVolumeClaim:

claimName: nas-2-oracle-rac-213-0

- name: ora-blk3

persistentVolumeClaim:

claimName: nas-3-oracle-rac-213-0

- name: ora-blk4

persistentVolumeClaim:

claimName: nas-4-oracle-rac-213-0

- name: tmpfs

emptyDir:

medium: Memory

sizeLimit: 4Gi

- name: hp

hostPath:

path: /dev/hugepages

- name: cgroups

hostPath:

path: /sys/fs/cgroup

type: Directory

- name: proc

hostPath:

path: /home/hostproc

type: Directory

- name: boot

hostPath:

path: /boot

type: Directory

volumeClaimTemplates:

- metadata:

name: nas-0

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

- metadata:

name: nas-1

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

- metadata:

name: nas-2

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

- metadata:

name: nas-3

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

- metadata:

name: nas-4

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

Сначала создадим пространство имен:

---

apiVersion: v1

kind: Namespace

metadata:

name: oracle-rac-213

labels:

kubernetes.io/metadata.name: oracle-rac-213

pod-security.kubernetes.io/enforce: privileged

spec:

finalizers:

- kubernetes

Всвязи с отменой podSecurityPolicy с версии 1.23, часть настроек осуществляется в пространстве имен.

По моему мнению любой CNI можно настроить на добавление дополнительных адаптеров контейнеру при запуске.

Для сокращения времени внедрения я использую готовое решение multus, одобренное cncf. При развертывании multus CNI в кластере kubernetes я советую обратить внимание на возможность развертывания только на узлах, где будут работать контейнеры RAC. Даже при отсутствии аннотаций в манифестах никакие контейнеры могут не запуститься по причине некорректных настроек после раскатки multus CNI. Сразу обратите внимание на файл /etc/cni/net.d/00-multus.conf

{ "cniVersion": "0.3.1", "name": "multus-cni-network", "type": "multus", "capabilities": {"portMappings": true}, "kubeconfig": "/etc/cni/net.d/multus.d/multus.kubeconfig", "delegates": [ { "cniVersion": "0.3.1", "name" ……

В будущих версиях containerd это может сработать и так, но сегодня при каждом запуске узла kubernetes этот файл обновляется и для корректной работы значение cniVersion должно быть 0.3.1.

Добавить определения сетей:

---

apiVersion: "k8s.cni.cncf.io/v1"

kind: NetworkAttachmentDefinition

metadata:

name: macvlan-conf

spec:

config: '{

"cniVersion": "0.3.1",

"plugins": [

{

"type": "macvlan",

"capabilities": { "ips": true },

"master": "cni0",

"mode": "bridge",

"ipam": {

"type": "static",

"routes": [

{

"dst": "0.0.0.0/0",

"gw": "172.16.1.1"

}

]

}

}

]

}'

---

apiVersion: "k8s.cni.cncf.io/v1"

kind: NetworkAttachmentDefinition

metadata:

name: macvlan-priv-conf

spec:

config: '{

"cniVersion": "0.3.1",

"plugins": [

{

"type": "macvlan",

"capabilities": { "ips": true },

"master": "enp2s0f1",

"mtu": 1500,

"mode": "bridge",

"ipam": {

"type": "static"

}

}

]

}'

Я специально написал mtu 1500 для приватной сети, зная, что требуются jumbo packets с mtu 9000 и мы получим предупреждение при развертывании grid в журналах. Ничего страшного в этом нет, просто для этой настройки потребуется еще немало работы, которая не входит в текущие планы. Вполне может оказаться, что 20% ускорения при использовании jumbo packets не скажется на общей производительности.

spec. securityContext:sysctls: именно здесь можно объявить для использования в контейнере часть параметров ядра, остальные можно установить на уровне рабочего узла kubernetes.

Для этого используется featureGates на рабочем узле, в файл /var/lib/kubelet/config.yaml добавить строку:

allowedUnsafeSysctls: [kernel.shm*, kernel.sem, net.*]

В файл /etc/kubernetes/manifests/kube-apiserver.yaml добавить

--feature-gates=ProcMountType=true

API server kubernetes перезапустится в течение нескольких минут, API ресурсы кластера будут недоступны. На этом пункте важно понимать что и зачем вы делаете, иначе вы можете потерять свой кластер kubernetes.

Перезапустить kubelet, swap до этого момента должен быть все еще отключен.

Можно ничего этого не делать, просто все sysctl на уровне хоста добавить в /etc/sysctl.conf и sysctl -p, вопрос перфекционизма. Все требуемое официальной документацией Oracle туда тоже следует непременно добавить.

Для ускорения загрузки образа (20Gi) лучше настроить любой локальный реестр образов.

Потом

podman pull container-registry.oracle.com/database/rac:21.3.0.0

podman push --tls-verify=false <image> docker-service.docker-registry:5000/container-registry.oracle.com/database/rac:21.3.0.0

Для настройки mirror registry в config.toml добавьте имя и порт вашего реестра:

[plugins."io.containerd.grpc.v1.cri".registry.configs]

[plugins."io.containerd.grpc.v1.cri".registry.configs."cr.local:32424"]

[plugins."io.containerd.grpc.v1.cri".registry.configs."cr.local:32424".tls]

insecure_skip_verify = true

[plugins."io.containerd.grpc.v1.cri".registry.headers]

[plugins."io.containerd.grpc.v1.cri".registry.mirrors]

[plugins."io.containerd.grpc.v1.cri".registry.mirrors."cr.local:32424"]

endpoint = ["https://cr.local:32424"]

В этом примере podman работает в своем контейнере и порт хранилища используется в сети кластера kubernetes, а containerd работает с сетью хоста, поэтому мы видим порт из сервиса деплоймента podman в kubernetes.

securityContext:

privileged: true

Здесь нет никакой ошибки, именно на уровне контейнера и объявляется второй блок securityContext. При сравнении с официальной docker конфигурацией Oracle выясняется существенная разница в работе docker и kubernetes.

Очень важно определиться на каком оборудовании можно и нужно использовать huge pages. По моему личному мнению, основанному на рекомендациях Oracle, официально определенную величину vm.nr_hugepages=16384 не стоит использовать на серверах с объемом физической оперативной памяти менее 64Gb. Попробовать можно, скорее всего база Oracle не стартует. Просто не используйте ее:

sysctl vm.nr_hugepages=0

Сервер БД Oracle сам переключится на использование обычных страниц, которых должно быть достаточно. Тогда следует коррелировать размер SGA и выделенной области /dev/shm. Тут они 3.8Gb и 4Gb соответственно.

Не забудьте отключить transparent huge pages во всех случаях:

sudo echo never > /sys/kernel/mm/transparent_hugepage/enabled

Лучше это сделать на уровне GRUB заранее.

# Init script

sudo mv /etc/ntp.conf /etc/ntp.conf-

sudo ln -s /oradata/.secrets/common_os_pwdfile.enc /run/secrets/common_os_pwdfile.enc

sudo ln -s /oradata/.secrets/pwd.key /run/secrets/pwd.key

sudo mount --bind /hostproc/net/core /proc/sys/net/core

sudo echo 950000 > /sys/fs/cgroup/cpu/system.slice/cpu.rt_runtime_us

sudo sysctl kernel.sched_rt_runtime_us=-1

sudo sed -i 's/134217728$/8388608/' /etc/security/limits.conf

sudo yum -y install chrony

sudo systemctl start chronyd

Переименование файла ntp.conf, чтобы избежать ошибки cvu. Непонятно, зачем он оказался в этом образе.

Шифрование начального пароля и размещение закрытого ключа описано в документации Oracle, просто поместите те файлы сюда.

Далее идет трюк на грани фола. Невозможно пока отобразить все нужные параметры ядра, чтобы cvu check был чистым, скопируйте в обычную файловую систему участок

sudo cp -r /proc/sys/net /home/<…>

В этом командном файле mount --bind успешно подмонтирует этот кусочек в /proc контейнера и мы не увидим ни одной ошибки cvu ни журналов контейнера.

kernel.sched_rt_runtime_us=-1 на этой «-1» тут, честно говоря все и держится Данный параметр позволяет root процессам контейнера запускать процессы с приоритетом RT. ASM с версии 19.3 по другому работать не будет. 18.3 еще работает.

Данный параметр позволяет root процессам контейнера запускать процессы с приоритетом RT. ASM с версии 19.3 по другому работать не будет. 18.3 еще работает.

Система должна быть загружена со значением DefaultCPUAccounting=no в /etc/systemd/system.conf Иначе не заработает realtime в контейнере.

/etc/security/limits.conf содержит нереальное значение memlock 128Gb, база запускаться не будет, поэтому для системы 20Gb на все выделим по 8Gb на ASM и 8Gb на Oracle.

Chronyd пришел на смену ntp и он тут стартует.

Данный файл следует выполнить в первые 60 секунд работы контейнера, для этого там время и выделено.

kubectl -n oracle-rac-213 exec -it oracle-rac-213-0 -- bash /oradata/scripts/ini.sh

Подготовьте 2 или более файла на nfs серверах согласно документации Oracle.

Я использую немного другое, но очень быстрое решение:

cd /home/oracle-rac-213/

sudo fallocate -z -o 0 -l 23G asm_disk01.img

sudo fallocate -z -o 0 -l 23G asm_disk02.img

sudo fallocate -z -o 0 -l 23G asm_disk03.img

sudo fallocate -z -o 0 -l 23G asm_disk04.img

sudo fallocate -z -o 0 -l 23G asm_disk05.img

Наличие нулевых блоков хранится в метаданных файловой системы.

На рабочем узле kubernetes смонтируйте шару:

mkdir -p /mnt/ora

mount -t nfs 192.168.1.4:/home/oracle-rac-213 /mnt/ora

Смонтируйте каждый файл как устройство:

losetup -f /mnt/ora/asm_disk01.img

… И т.д.

Теперь можно объявить все persistent volumes:

---

kind: PersistentVolume

apiVersion: v1

metadata:

name: nas-0

spec:

volumeMode: Block

capacity:

storage: 23Gi

local:

path: /dev/loop0

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

nodeAffinity:

required:

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/hostname

operator: In

values:

- r02

Все объявить надо.

Persistent volume claims у нас объявлены в statefulset manifest.

apiVersion: v1

kind: ConfigMap

metadata:

name: oracle-rdbms-config

labels:

app: oracle-rac-213

data:

# IGNORE_CVU_CHECKS: "true"

#

CLUSTER_NAME: "ora-213"

# DHCP_CONF: "TRUE"

NODE_VIP: "172.16.1.160"

VIP_HOSTNAME: "oracle-rac-213-0-v"

PUBLIC_IP: "172.16.1.150"

PUBLIC_HOSTNAME: "oracle-rac-213-0"

SCAN_NAME: "ora-scan"

# SCAN_IP: "172.16.1.70"

PRIV_IP: "192.168.17.150"

PRIV_HOSTNAME: "oracle-rac-213-0-p"

#

# CMAN_IP: "172.16.1.15"

# CMAN_HOSTNAME: "cman-1"

#

COMMON_OS_PWD_FILE: "common_os_pwdfile.enc"

PWD_KEY: "pwd.key"

#

DOMAIN: "oracle-rac-213.svc.cluster.local"

# DNS_SEARCH: "10.96.0.10"

# DNS_SERVERS: "192.168.1.1" #"10.96.0.10"

# DEFAULT_GATEWAY: "172.16.1.1" # within container

ASM_DEVICE_LIST: "/dev/asm_disk01,/dev/asm_disk02,/dev/asm_disk03,/dev/asm_disk04,/dev/asm_disk05"

ASM_DISCOVERY_DIR: "/dev"

# GRID_RESPONSE_FILE: "grid_sample.rsp"

# DBCA_RESPONSE_FILE: "dbca_sample.rsp"

OP_TYPE: "INSTALL"

Не указываю явно DNS сервер, нормальный режим работы Oracle, он будет ориентироваться на resolv.conf, далее cluster dns. Главное в этой цепочке указать соответствие имен хостов из этого списка и их адресов, для SCAN указать все 3 адреса 172.16.1.70 - 172.16.1.72. Я использовал dns сервер из внешнего к кластеру kubernetes сетевого домена, поэтому пришлось указывать все 2 раза с доменом и без. Имя домена в контейнере образуется по правилам kubernetes: oracle-rac-213.svc.cluster.local

sudo chmod 600 /swap.img

sudo mkswap /swap.img

sudo swapon /swap.img

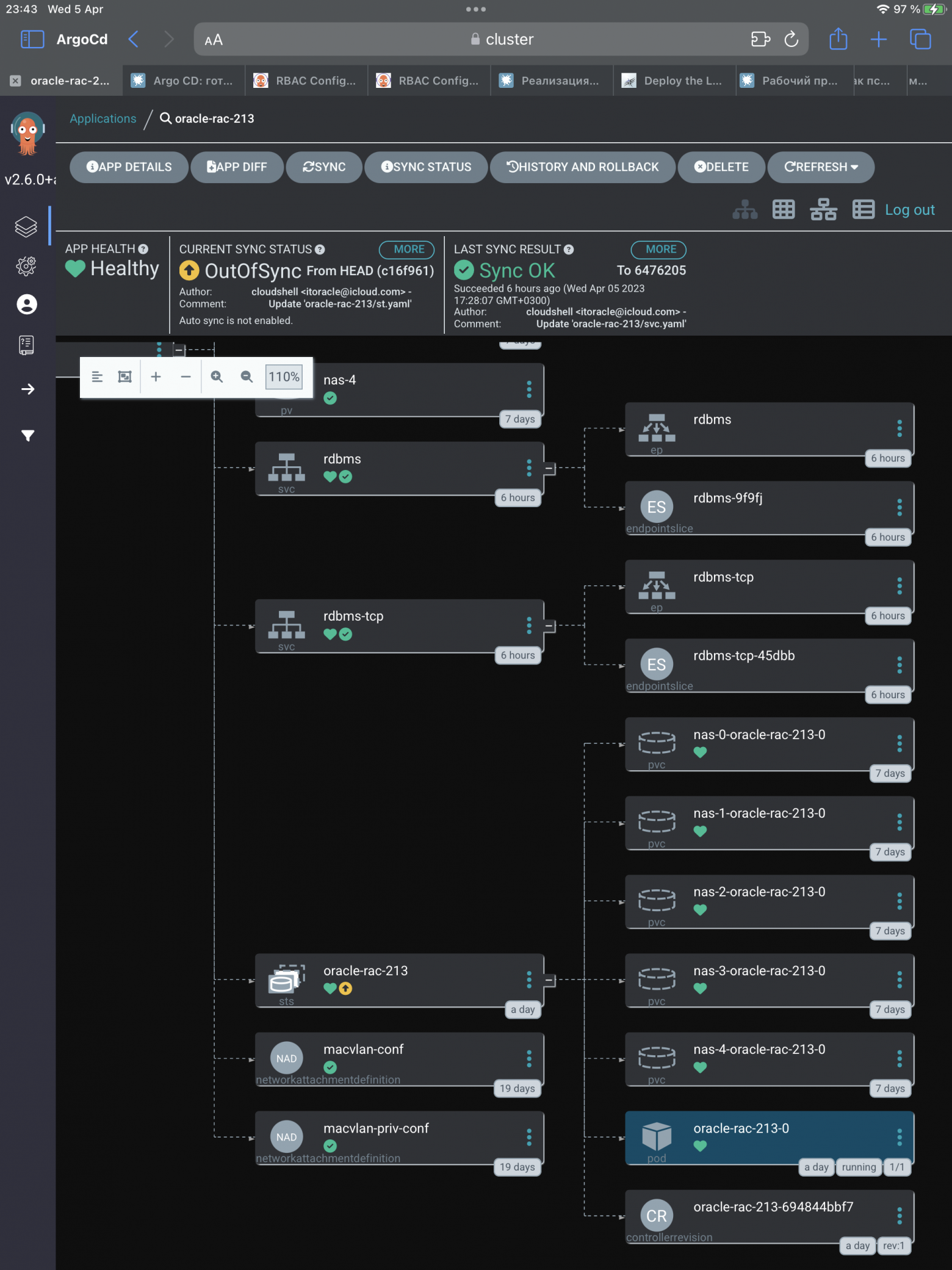

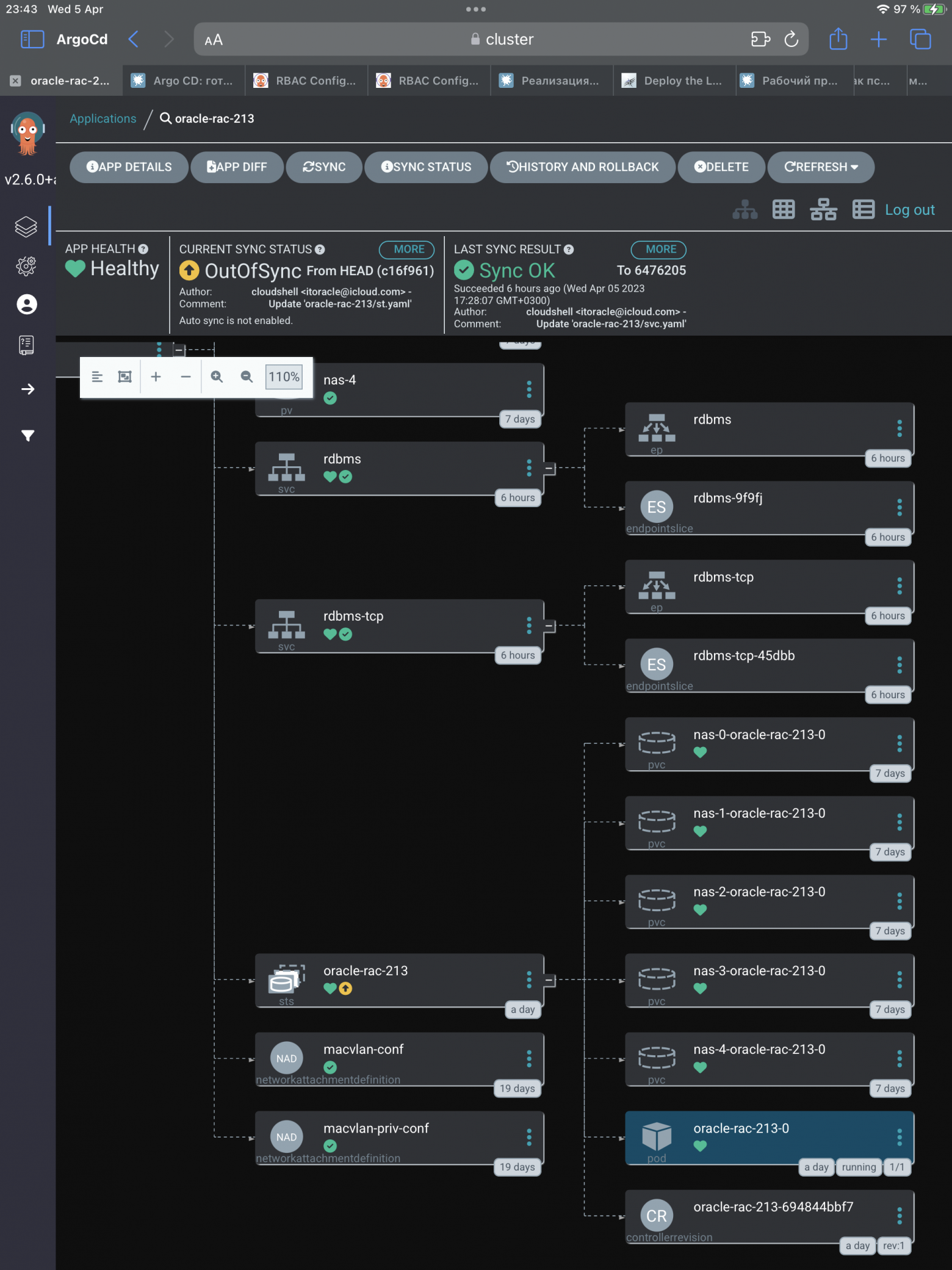

Я использую Argocd:

Основные компоненты

Сервисы для доступа к БД и OEM можно получить в моем репозитории https://github.com/itoracl/oracle-rac-213, как и все вышеприведенные манифесты.

Для вашей системы потребуется дополнительная настройка доступа к БД извне кластера. CMAN это опция и его можно и нужно настроить дополнительно.

Примерно через час видим полный good luck screen

Выполним внутри контейнера:

[grid@oracle-rac-213-0 ~] $ crsctl check crs

CRS-4638: Oracle High Availability Services is online

CRS-4537: Cluster Ready Services is online

CRS-4529: Cluster Synchronization Services is online

CRS-4533: Event Manager is online

[grid@oracle-rac-213-0 ~] $ crsctl status resource -w "TYPE co ’ora’" -t

--------------------------------------------------------------------------------

Name Target State Server State details

--------------------------------------------------------------------------------

Local Resources

--------------------------------------------------------------------------------

ora.LISTENER.lsnr

ONLINE ONLINE oracle-rac-213-0 STABLE

ora.chad

ONLINE ONLINE oracle-rac-213-0 STABLE

ora.net1.network

ONLINE ONLINE oracle-rac-213-0 STABLE

ora.ons

ONLINE ONLINE oracle-rac-213-0 STABLE

--------------------------------------------------------------------------------

Cluster Resources

--------------------------------------------------------------------------------

ora.ASMNET1LSNR_ASM.lsnr(ora.asmgroup)

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.DATA.dg(ora.asmgroup)

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.LISTENER_SCAN1.lsnr

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.LISTENER_SCAN2.lsnr

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.LISTENER_SCAN3.lsnr

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.asm(ora.asmgroup)

1 ONLINE ONLINE oracle-rac-213-0 Started,STABLE

ora.asmnet1.asmnetwork(ora.asmgroup)

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.cdp1.cdp

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.cdp2.cdp

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.cdp3.cdp

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.cvu

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.oracle-rac-213-0.vip

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.orclcdb.db

1 ONLINE ONLINE oracle-rac-213-0 Open,HOME=/u01/app/o

racle/product/21.3.0

/dbhome_1,STABLE

ora.orclcdb.orclpdb.pdb

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.qosmserver

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.scan1.vip

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.scan2.vip

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.scan3.vip

1 ONLINE ONLINE oracle-rac-213-0 STABLE

--------------------------------------------------------------------------------

Как там чувствуют себя процессы:

[grid@oracle-rac-213-0 ~]$ sudo ps -Fel

F S UID PID PPID C PRI NI ADDR SZ WCHAN RSS PSR STIME TTY TIME CMD

4 S root 1 0 0 80 0 - 18687 ep_pol 7172 5 Apr04 ? 00:00:04

4 S root 19 1 0 80 0 - 12093 ep_pol 14640 1 Apr04 ? 00:00:01 /usr/lib/systemd/systemd-journald

4 S dbus 48 1 0 80 0 - 14526 ep_pol 4516 2 Apr04 ? 00:00:01 /usr/bin/dbus-daemon --system --address=systemd: --nofork --nopidfile --systemd-activation

5 S rpc 49 1 0 80 0 - 17317 poll_s 3368 6 Apr04 ? 00:00:00 /sbin/rpcbind -w

5 S root 56 1 0 80 0 - 22881 ep_pol 2720 5 Apr04 ? 00:00:00 /usr/sbin/gssproxy -D

4 S root 72 1 0 80 0 - 6656 ep_pol 3124 0 Apr04 ? 00:00:00 /usr/lib/systemd/systemd-logind

4 S root 73 1 0 80 0 - 13223 hrtime 5064 5 Apr04 ? 00:00:00 /usr/sbin/smartd -n -q never

4 S root 81 1 0 80 0 - 5678 hrtime 2756 5 Apr04 ? 00:00:00 /usr/sbin/crond -n

4 S root 214 1 0 80 0 - 28237 poll_s 8024 7 Apr04 ? 00:00:00 /usr/sbin/sshd -D

4 S root 219 1 0 80 0 - 27922 wait_w 2232 2 Apr04 tty1 00:00:00 /sbin/agetty --noclear tty1 linux

5 S chrony 367 1 0 80 0 - 25127 poll_s 3152 1 Apr04 ? 00:00:00 /usr/sbin/chronyd

4 S root 11575 1 0 80 0 - 2958 do_wai 2868 1 Apr04 ? 00:00:01 /bin/sh /etc/init.d/init.tfa run >/dev/null 2>&1 </dev/null

4 S root 12746 1 0 80 0 - 2959 pipe_w 2760 5 Apr04 ? 00:00:00 /bin/sh /etc/init.d/init.ohasd run >/dev/null 2>&1 </dev/null

4 S root 20700 1 0 80 0 - 817029 futex_ 131196 3 Apr04 ? 00:02:07 /u01/app/21.3.0/grid/bin/ohasd.bin reboot BLOCKING_STACK_LOCALE_OHAS=AMERICAN_AMERICA.WE8ISO8859P1

4 S root 20801 1 0 80 0 - 509019 futex_ 114976 2 Apr04 ? 00:01:09 /u01/app/21.3.0/grid/bin/orarootagent.bin

4 S grid 20889 1 0 80 0 - 424096 futex_ 102324 7 Apr04 ? 00:01:46 /u01/app/21.3.0/grid/bin/oraagent.bin

4 S grid 20912 1 0 80 0 - 107668 poll_s 34940 4 Apr04 ? 00:00:39 /u01/app/21.3.0/grid/bin/mdnsd.bin

4 S grid 20914 1 0 80 0 - 231782 ep_pol 53252 5 Apr04 ? 00:01:30 /u01/app/21.3.0/grid/bin/evmd.bin

4 S grid 20947 1 0 80 0 - 279095 hrtime 46768 0 Apr04 ? 00:00:45 /u01/app/21.3.0/grid/bin/gpnpd.bin

4 S grid 20999 20914 0 80 0 - 110191 poll_s 39388 3 Apr04 ? 00:00:40 /u01/app/21.3.0/grid/bin/evmlogger.bin -o /u01/app/21.3.0/grid/log/[HOSTNAME]/evmd/evmlogger.info -l /u01/app/21.3.0/grid/log/[HOSTNAME]/e

vmd/evmlogger.log

4 S grid 21018 1 0 80 0 - 219524 hrtime 73508 1 Apr04 ? 00:01:34 /u01/app/21.3.0/grid/bin/gipcd.bin

4 S root 21060 1 0 -40 - - 295798 futex_ 159344 1 Apr04 ? 00:00:42 /u01/app/21.3.0/grid/bin/cssdmonitor

4 S root 21062 1 0 30 - - 415971 hrtime 184224 1 Apr04 ? 00:03:28 /u01/app/21.3.0/grid/bin/osysmond.bin

4 S root 21096 1 0 -40 - - 329843 futex_ 165852 4 Apr04 ? 00:00:41 /u01/app/21.3.0/grid/bin/cssdagent

4 S grid 21113 1 0 -40 - - 550843 futex_ 210708 7 Apr04 ? 00:01:19 /u01/app/21.3.0/grid/bin/onmd.bin -S 1

4 S grid 21115 1 0 -40 - - 276213 futex_ 163228 0 Apr04 ? 00:01:17 /u01/app/21.3.0/grid/bin/ocssd.bin -S 1

4 S root 21469 1 0 80 0 - 247004 futex_ 44256 2 Apr04 ? 00:01:36 /u01/app/21.3.0/grid/bin/octssd.bin reboot

4 S root 21541 1 0 80 0 - 278565 poll_s 246248 7 Apr04 ? 00:01:18 /u01/app/21.3.0/grid/bin/ologgerd -M

4 S grid 21709 1 0 80 0 - 401337 do_sem 89704 5 Apr04 ? 00:00:01 asm_pmon_+ASM1

4 S grid 21715 1 0 80 0 - 401338 do_sem 75892 0 Apr04 ? 00:00:01 asm_clmn_+ASM1

4 S grid 21720 1 0 80 0 - 401338 do_sem 78420 3 Apr04 ? 00:00:03 asm_psp0_+ASM1

4 S grid 21724 1 0 58 - - 401338 hrtime 75524 0 Apr04 ? 00:03:11 asm_vktm_+ASM1

4 S grid 21730 1 0 80 0 - 405519 do_sem 94880 7 Apr04 ? 00:00:02 asm_gen0_+ASM1

4 S grid 21754 1 0 80 0 - 401337 do_sem 74076 6 Apr04 ? 00:00:00 asm_mman_+ASM1

4 S grid 21760 1 0 80 0 - 409138 poll_s 118480 4 Apr04 ? 00:00:23 asm_lmon_+ASM1

4 S grid 21764 1 0 80 0 - 431391 do_sem 80028 7 Apr04 ? 00:00:02 asm_gen1_+ASM1

4 S grid 21766 1 0 80 0 - 401338 do_sem 74572 7 Apr04 ? 00:00:00 asm_gen2_+ASM1

4 S grid 21768 1 0 80 0 - 434974 do_sem 104712 3 Apr04 ? 00:00:43 asm_lms0_+ASM1

4 S grid 21773 1 0 80 0 - 401338 do_sem 76280 0 Apr04 ? 00:00:00 asm_vosd_+ASM1

4 S grid 21775 1 0 80 0 - 403062 poll_s 92640 6 Apr04 ? 00:00:13 asm_diag_+ASM1

4 S grid 21781 1 0 80 0 - 404921 poll_s 90304 2 Apr04 ? 00:00:01 asm_ping_+ASM1

4 S grid 21790 1 0 80 0 - 401338 do_sem 77572 3 Apr04 ? 00:00:03 asm_pman_+ASM1

4 S grid 21793 1 0 80 0 - 405801 poll_s 117228 7 Apr04 ? 00:00:42 asm_dia0_+ASM1

4 S grid 21798 1 0 80 0 - 408782 poll_s 96676 1 Apr04 ? 00:00:20 asm_lmd0_+ASM1

4 S grid 21801 1 0 80 0 - 403500 poll_s 108768 6 Apr04 ? 00:00:24 asm_lmhb_+ASM1

4 S grid 21809 1 0 80 0 - 401338 do_sem 77852 2 Apr04 ? 00:00:00 asm_lck1_+ASM1

4 S grid 21811 1 0 80 0 - 402962 do_sem 96240 3 Apr04 ? 00:00:00 asm_dbw0_+ASM1

4 S grid 21813 1 0 58 - - 401549 do_sem 96624 7 Apr04 ? 00:00:01 asm_lgwr_+ASM1

4 S grid 21817 1 0 80 0 - 401337 do_sem 99256 4 Apr04 ? 00:00:02 asm_ckpt_+ASM1

4 S grid 21819 1 0 80 0 - 401338 do_sem 75244 3 Apr04 ? 00:00:00 asm_smon_+ASM1

4 S grid 21821 1 0 80 0 - 403134 ep_pol 84064 6 Apr04 ? 00:00:00 asm_lreg_+ASM1

4 S grid 21823 1 0 80 0 - 482480 do_sem 90184 6 Apr04 ? 00:00:02 asm_bg00_+ASM1

4 S grid 21827 1 0 80 0 - 401338 do_sem 75388 6 Apr04 ? 00:00:00 asm_pxmn_+ASM1

4 S grid 21831 1 0 80 0 - 406147 do_sem 106944 3 Apr04 ? 00:00:02 asm_rbal_+ASM1

4 S grid 21839 1 0 80 0 - 406054 do_sem 101380 3 Apr04 ? 00:00:03 asm_gmon_+ASM1

4 S grid 21845 1 0 80 0 - 405160 do_sem 89820 3 Apr04 ? 00:00:01 asm_mmon_+ASM1

4 S grid 21848 1 0 80 0 - 401338 do_sem 98088 6 Apr04 ? 00:00:09 asm_mmnl_+ASM1

4 S grid 21853 1 0 80 0 - 482272 do_sem 84680 6 Apr04 ? 00:00:02 asm_bg01_+ASM1

4 S grid 21861 1 0 80 0 - 401449 do_sem 81956 0 Apr04 ? 00:00:34 asm_imr0_+ASM1

4 S grid 21867 1 0 80 0 - 401272 do_sem 77648 2 Apr04 ? 00:00:05 asm_scm0_+ASM1

4 S grid 21881 1 0 80 0 - 401770 poll_s 88032 5 Apr04 ? 00:00:02 asm_lck0_+ASM1

4 S grid 21931 1 0 80 0 - 401793 do_sem 101820 2 Apr04 ? 00:01:07 asm_gcr0_+ASM1

4 S grid 23369 1 0 80 0 - 402095 pipe_w 88824 6 Apr04 ? 00:00:02 asm_asmb_+ASM1

4 S grid 23377 1 0 80 0 - 405882 do_sem 93612 5 Apr04 ? 00:00:04 oracle+ASM1_asmb_+asm1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S root 23386 1 0 80 0 - 1113981 futex_ 159168 3 Apr04 ? 00:03:59 /u01/app/21.3.0/grid/bin/crsd.bin reboot

4 S grid 23599 1 0 80 0 - 402364 pipe_w 105516 2 Apr04 ? 00:00:01 oracle+ASM1_ocr (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S root 24050 1 0 80 0 - 1467664 futex_ 371004 3 Apr04 ? 00:03:10 /opt/oracle.ahf/jre/bin/java -server -Xms128m -Xmx256m -Djava.awt.headless=true -Ddisable.checkForUpdate=true -XX:HeapDumpPath=/u01/app/gr

id/oracle.ahf/data/oracle-rac-213-0/diag/tfa oracle.rat.tfa.TFAMain /opt/oracle.ahf/tfa

4 S grid 24330 1 0 80 0 - 2429 do_wai 2748 1 Apr04 ? 00:00:06 /bin/sh ./OSWatcher.sh 30 48 NONE /u01/app/grid/oracle.ahf/data/repository/suptools/oracle-rac-213-0/oswbb/grid/archive

4 S grid 24513 24330 0 80 0 - 2395 do_wai 2580 0 Apr04 ? 00:00:03 /bin/sh ./OSWatcherFM.sh 48 /u01/app/grid/oracle.ahf/data/repository/suptools/oracle-rac-213-0/oswbb/grid/archive

4 S root 25884 1 0 80 0 - 326980 futex_ 90992 0 Apr04 ? 00:05:35 /u01/app/21.3.0/grid/bin/orarootagent.bin

4 S grid 25917 1 0 80 0 - 716267 futex_ 139864 2 Apr04 ? 00:03:07 /u01/app/21.3.0/grid/bin/oraagent.bin

4 S grid 25942 1 0 80 0 - 35739 ep_pol 23928 7 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr ASMNET1LSNR_ASM -no_crs_notify -inherit

4 S grid 26001 1 0 80 0 - 402181 pipe_w 102188 7 Apr04 ? 00:00:00 oracle+ASM1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

5 S grid 26143 1 0 80 0 - 6873 do_wai 580 5 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/opmn/bin/ons -d

5 S grid 26144 26143 0 80 0 - 75513 futex_ 11328 2 Apr04 ? 00:00:01 /u01/app/21.3.0/grid/opmn/bin/ons -d

4 S grid 26279 1 0 80 0 - 68666 ep_pol 23956 2 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr LISTENER_SCAN1 -no_crs_notify -inherit

4 S grid 26302 1 0 80 0 - 68666 ep_pol 23992 1 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr LISTENER_SCAN2 -no_crs_notify -inherit

4 S grid 26323 1 0 80 0 - 68667 ep_pol 24184 6 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr LISTENER_SCAN3 -no_crs_notify -inherit

4 S grid 26395 1 0 80 0 - 208633 futex_ 55360 4 Apr04 ? 00:00:45 /u01/app/21.3.0/grid/bin/scriptagent.bin

4 S grid 26625 1 0 80 0 - 1288136 futex_ 420932 4 Apr04 ? 00:04:04 /u01/app/21.3.0/grid/jdk/bin/java -server -Xms128M -Xmx512M -Djava.awt.headless=true -Ddisable.checkForUpdate=true -Djava.security.propert

ies=/u01/app/grid/crsdata/oracle-rac-213-0/qos/conf/qos.security -Djdk.tls.client.protocols="TLSv1.2,TLSv1.3" -Dhttps.protocols="TLSv1.2,TLSv1.3" -Djava.util.logging.config.file=/u01/app/grid/crsdata/oracle-rac-213-0/qos/conf/l

ogging.properties -Djava.util.logging.manager=org.apache.juli.ClassLoaderLogManager -DTRACING.ENABLED=false -Djava.rmi.server.hostname=oracle-rac-213-0 -Doracle.http.port=8888 -Doracle.jmx.port=8895 -Doracle.tls.enabled=false -

Doracle.jwc.tls.http.enabled=true -Doracle.wlm.dbwlm.always_on=true -Djava.security.manager -Djava.security.policy=/u01/app/grid/crsdata/oracle-rac-213-0/qos/conf/catalina.policy -Djava.security.egd=file:/dev/urandom -XX arall

arall

elGCThreads=2 -Doracle.rest.enabled=true -Doracle.jmx.enabled=true -Dcatalina.home=/u01/app/21.3.0/grid/tomcat -Dcatalina.base=/u01/app/grid/crsdata/oracle-rac-213-0/qos -Djava.io.tmpdir=/u01/app/grid/crsdata/oracle-rac-213-0/q

os/temp -Doracle.home=/u01/app/21.3.0/grid -Doracle.jwc.mode=CLUSTERWARE -classpath /u01/app/21.3.0/grid/jlib/cryptoj.jar:/u01/app/21.3.0/grid/jlib/oraclepki.jar:/u01/app/21.3.0/grid/jlib/osdt_core.jar:/u01/app/21.3.0/grid/jlib

/osdt_cert.jar:/u01/app/21.3.0/grid/tomcat/lib/tomcat-juli.jar:/u01/app/21.3.0/grid/tomcat/lib/bootstrap.jar:/u01/app/21.3.0/grid/jlib/jwc-logging.jar org.apache.catalina.startup.Bootstrap start

0 S grid 27153 1 0 80 0 - 1066039 futex_ 192716 4 Apr04 ? 00:01:12 /u01/app/21.3.0/grid/jdk/bin/java -server -Xms30M -Xmx1024M -Djava.awt.headless=true -Ddisable.checkForUpdate=true -DTRACING.ENABLED=false

-XX arallelGCThreads=1 -cp /u01/app/21.3.0/grid/jlib/cha.jar:/u01/app/21.3.0/grid/jlib/chaconfig.jar:/u01/app/21.3.0/grid/jlib/cha-diag-msg.jar:/u01/app/21.3.0/grid/jlib/clsce.jar:/u01/app/21.3.0/grid/jlib/srvm.jar:/u01/app/2

arallelGCThreads=1 -cp /u01/app/21.3.0/grid/jlib/cha.jar:/u01/app/21.3.0/grid/jlib/chaconfig.jar:/u01/app/21.3.0/grid/jlib/cha-diag-msg.jar:/u01/app/21.3.0/grid/jlib/clsce.jar:/u01/app/21.3.0/grid/jlib/srvm.jar:/u01/app/2

1.3.0/grid/jlib/srvmhas.jar:/u01/app/21.3.0/grid/jlib/srvmasm.jar:/u01/app/21.3.0/grid/jlib/netcfg.jar:/u01/app/21.3.0/grid/jdbc/lib/ojdbc8.jar:/u01/app/21.3.0/grid/ucp/lib/ucp.jar:/u01/app/21.3.0/grid/jlib/fte.jar:/u01/app/21.

3.0/grid/jlib/jai_core.jar:/u01/app/21.3.0/grid/jlib/mlibwrapper_jai.jar:/u01/app/21.3.0/grid/jlib/vecmath.jar:/u01/app/21.3.0/grid/jlib/jai_codec.jar:/u01/app/21.3.0/grid/jlib/jh.jar:/u01/app/21.3.0/grid/jlib/lucene-core-8.1.1

.jar oracle.cha.server.CHADDriver

4 S grid 27422 1 0 80 0 - 402146 pipe_w 96552 5 Apr04 ? 00:00:00 oracle+ASM1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S grid 27711 1 0 80 0 - 313505 futex_ 51048 6 Apr04 ? 00:01:03 /u01/app/21.3.0/grid/bin/crscdpd.bin

4 S grid 27769 1 0 80 0 - 313505 futex_ 49432 1 Apr04 ? 00:01:03 /u01/app/21.3.0/grid/bin/crscdpd.bin

4 S grid 28015 1 0 80 0 - 313505 futex_ 49776 6 Apr04 ? 00:01:02 /u01/app/21.3.0/grid/bin/crscdpd.bin

4 S grid 28744 1 0 80 0 - 74214 ep_pol 28552 4 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr LISTENER -no_crs_notify -inherit

4 S grid 28788 1 0 80 0 - 824812 futex_ 74460 0 Apr04 ? 00:00:55 /u01/app/21.3.0/grid/jdk/bin/java -Xms128M -Xmx384M -classpath /u01/app/21.3.0/grid/jdk/jre/lib/rt.jar:/u01/app/21.3.0/grid/jdk/jre/lib/i1

8n.jar:/u01/app/21.3.0/grid/jlib/jagent.jar:/u01/app/21.3.0/grid/jlib/srvm.jar: -Dora.jagent.conf=conf/orajagent.conf oracle.jagent.core.OraJavaAgentDriver

4 S oracle 79326 1 0 80 0 - 377232 futex_ 107320 2 Apr04 ? 00:01:05 /u01/app/21.3.0/grid/bin/oraagent.bin

4 S oracle 79418 1 0 80 0 - 1155448 do_sem 77140 2 Apr04 ? 00:00:01 ora_pmon_ORCLCDB1

4 S oracle 79422 1 0 80 0 - 1155448 do_sem 74232 7 Apr04 ? 00:00:00 ora_clmn_ORCLCDB1

4 S oracle 79426 1 0 80 0 - 1155482 do_sem 74196 6 Apr04 ? 00:00:03 ora_psp0_ORCLCDB1

4 S oracle 79430 1 0 80 0 - 1155939 ep_pol 87036 3 Apr04 ? 00:00:32 ora_ipc0_ORCLCDB1

4 S oracle 79434 1 0 58 - - 1155448 hrtime 72708 5 Apr04 ? 00:02:51 ora_vktm_ORCLCDB1

4 S oracle 79440 1 0 80 0 - 1162043 do_sem 147920 0 Apr04 ? 00:00:01 ora_gen0_ORCLCDB1

4 S oracle 79444 1 0 80 0 - 1155449 do_sem 759988 5 Apr04 ? 00:00:01 ora_mman_ORCLCDB1

4 S oracle 79450 1 0 80 0 - 1163850 ep_pol 236596 3 Apr04 ? 00:00:19 ora_lmon_ORCLCDB1

4 S oracle 79454 1 0 80 0 - 1186455 do_sem 100184 4 Apr04 ? 00:00:04 ora_gen1_ORCLCDB1

4 S oracle 79456 1 0 80 0 - 1161013 do_sem 125000 7 Apr04 ? 00:00:00 ora_gen2_ORCLCDB1

4 S oracle 79458 1 0 80 0 - 1212565 do_sem 215368 0 Apr04 ? 00:00:46 ora_lms0_ORCLCDB1

4 S oracle 79460 1 0 80 0 - 1212564 do_sem 216680 0 Apr04 ? 00:00:46 ora_lms1_ORCLCDB1

4 S oracle 79466 1 0 80 0 - 1155449 do_sem 73284 1 Apr04 ? 00:00:00 ora_vosd_ORCLCDB1

4 S oracle 79468 1 0 80 0 - 1157178 ep_pol 89068 0 Apr04 ? 00:00:09 ora_diag_ORCLCDB1

4 S oracle 79470 1 0 80 0 - 1186711 do_sem 109432 0 Apr04 ? 00:00:00 ora_ofsd_ORCLCDB1

4 S oracle 79477 1 0 80 0 - 1161059 do_sem 232032 5 Apr04 ? 00:00:07 ora_dbrm_ORCLCDB1

4 S oracle 79479 1 0 80 0 - 1155449 do_sem 74336 1 Apr04 ? 00:00:14 ora_vkrm_ORCLCDB1

4 S oracle 79481 1 0 80 0 - 1161081 ep_pol 92648 4 Apr04 ? 00:00:00 ora_ping_ORCLCDB1

4 S oracle 79483 1 0 80 0 - 1157588 ep_pol 116544 7 Apr04 ? 00:00:01 ora_svcb_ORCLCDB1

4 S oracle 79488 1 0 80 0 - 1155449 do_sem 72556 1 Apr04 ? 00:00:00 ora_acms_ORCLCDB1

4 S oracle 79492 1 0 80 0 - 1155450 do_sem 74500 2 Apr04 ? 00:00:03 ora_pman_ORCLCDB1

4 S oracle 79495 1 0 80 0 - 1159403 ep_pol 111588 2 Apr04 ? 00:00:29 ora_dia0_ORCLCDB1

4 S oracle 79498 1 0 80 0 - 1155988 ep_pol 101548 3 Apr04 ? 00:00:16 ora_lmd0_ORCLCDB1

4 S oracle 79502 1 0 80 0 - 1155960 ep_pol 98636 0 Apr04 ? 00:00:15 ora_lmd1_ORCLCDB1

4 S oracle 79504 1 0 80 0 - 1155448 do_sem 73632 1 Apr04 ? 00:00:00 ora_rms0_ORCLCDB1

4 S oracle 79506 1 0 58 - - 1157615 ep_pol 104256 2 Apr04 ? 00:00:31 ora_lmhb_ORCLCDB1

4 S oracle 79510 1 0 80 0 - 1237460 do_sem 81888 2 Apr04 ? 00:00:02 ora_bg00_ORCLCDB1

4 S oracle 79515 1 0 80 0 - 1155448 do_sem 106416 4 Apr04 ? 00:00:04 ora_lck1_ORCLCDB1

4 S oracle 79518 1 0 80 0 - 1159021 do_sem 433048 2 Apr04 ? 00:00:04 ora_dbw0_ORCLCDB1

4 S oracle 79520 1 0 58 - - 1156248 do_sem 95964 0 Apr04 ? 00:00:03 ora_lgwr_ORCLCDB1

4 S oracle 79531 1 0 80 0 - 1161107 do_sem 142772 7 Apr04 ? 00:00:08 ora_ckpt_ORCLCDB1

4 S oracle 79537 1 0 80 0 - 1160779 do_sem 161356 3 Apr04 ? 00:00:00 ora_smon_ORCLCDB1

4 S oracle 79539 1 0 80 0 - 1155449 do_sem 74320 1 Apr04 ? 00:00:01 ora_smc RCLCDB1

RCLCDB1

4 S oracle 79541 1 0 80 0 - 1156654 do_sem 112500 2 Apr04 ? 00:00:00 ora_rec RCLCDB1

RCLCDB1

4 S oracle 79543 1 0 80 0 - 1158621 ep_pol 123216 7 Apr04 ? 00:00:00 ora_lreg_ORCLCDB1

4 S oracle 79548 1 0 80 0 - 1155449 do_sem 72640 7 Apr04 ? 00:00:00 ora_pxmn_ORCLCDB1

4 S oracle 79551 1 0 80 0 - 1237461 do_sem 82288 7 Apr04 ? 00:00:02 ora_bg01_ORCLCDB1

4 S oracle 79553 1 0 80 0 - 1160578 do_sem 90708 5 Apr04 ? 00:00:01 ora_rbal_ORCLCDB1

4 S oracle 79555 1 0 80 0 - 1156340 pipe_w 87012 3 Apr04 ? 00:00:02 ora_asmb_ORCLCDB1

4 S oracle 79557 1 0 80 0 - 1156016 hrtime 83288 3 Apr04 ? 00:00:11 ora_fenc_ORCLCDB1

4 S oracle 79559 1 0 80 0 - 1163357 do_sem 333044 4 Apr04 ? 00:00:07 ora_mmon_ORCLCDB1

4 S oracle 79561 1 0 80 0 - 1161059 do_sem 138128 6 Apr04 ? 00:00:06 ora_mmnl_ORCLCDB1

4 S oracle 79574 1 0 80 0 - 1155926 do_sem 88788 7 Apr04 ? 00:00:03 ora_lg00_ORCLCDB1

4 S oracle 79576 1 0 80 0 - 1161342 ep_pol 69936 1 Apr04 ? 00:00:00 ora_d000_ORCLCDB1

4 S grid 79578 1 0 80 0 - 406356 do_sem 103148 2 Apr04 ? 00:00:04 oracle+ASM1_asmb_orclcdb1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S oracle 79580 1 0 80 0 - 1155772 ep_pol 67832 5 Apr04 ? 00:00:00 ora_s000_ORCLCDB1

4 S oracle 79582 1 0 80 0 - 1156589 do_sem 142764 4 Apr04 ? 00:00:00 ora_w000_ORCLCDB1

4 S oracle 79584 1 0 80 0 - 1155926 do_sem 88472 2 Apr04 ? 00:00:00 ora_lg01_ORCLCDB1

4 S oracle 79586 1 0 80 0 - 1160274 do_sem 83172 2 Apr04 ? 00:00:21 ora_imr0_ORCLCDB1

4 S oracle 79588 1 0 80 0 - 1156112 do_sem 180744 3 Apr04 ? 00:00:00 ora_w001_ORCLCDB1

4 S oracle 79590 1 0 80 0 - 1155564 do_sem 76792 4 Apr04 ? 00:00:27 ora_imr1_ORCLCDB1

4 S oracle 79595 1 0 80 0 - 1156079 do_sem 132228 3 Apr04 ? 00:00:06 ora_scm0_ORCLCDB1

4 S oracle 79597 1 0 80 0 - 1156617 ep_pol 84524 3 Apr04 ? 00:00:04 ora_lck0_ORCLCDB1

4 S oracle 79601 1 0 80 0 - 1156634 ep_pol 78416 5 Apr04 ? 00:00:00 ora_rsmn_ORCLCDB1

4 S oracle 79603 1 0 80 0 - 1155450 do_sem 74220 4 Apr04 ? 00:00:00 ora_tmon_ORCLCDB1

4 S oracle 79632 1 0 80 0 - 1155563 do_sem 76668 2 Apr04 ? 00:00:57 ora_gcr0_ORCLCDB1

4 S oracle 79640 1 0 80 0 - 1155799 do_sem 74276 5 Apr04 ? 00:00:00 ora_mark_ORCLCDB1

4 S oracle 79823 1 0 80 0 - 1161167 do_sem 76804 2 Apr04 ? 00:00:00 ora_tt00_ORCLCDB1

4 S oracle 79825 1 0 80 0 - 1156147 do_sem 115508 6 Apr04 ? 00:00:00 ora_tt01_ORCLCDB1

4 S oracle 79839 1 0 80 0 - 1155385 hrtime 72056 7 Apr04 ? 00:00:00 ora_tt02_ORCLCDB1

4 S oracle 79876 1 0 80 0 - 1156796 do_sem 140180 1 Apr04 ? 00:00:00 ora_w002_ORCLCDB1

4 S oracle 79882 1 0 80 0 - 1160876 do_sem 142900 1 Apr04 ? 00:00:00 ora_w003_ORCLCDB1

4 S oracle 79891 1 0 80 0 - 1156088 do_sem 154680 2 Apr04 ? 00:00:00 ora_w004_ORCLCDB1

4 S oracle 79900 1 0 80 0 - 1155449 do_sem 73496 6 Apr04 ? 00:00:00 ora_gtx0_ORCLCDB1

4 S oracle 79907 1 0 80 0 - 1155804 do_sem 88020 3 Apr04 ? 00:00:00 ora_rcbg_ORCLCDB1

4 S oracle 79978 1 0 80 0 - 1156140 do_sem 98708 5 Apr04 ? 00:00:00 ora_aqpc_ORCLCDB1

4 S oracle 79984 1 0 80 0 - 1158392 ep_pol 231932 7 Apr04 ? 00:00:03 ora_p000_ORCLCDB1

4 S oracle 79986 1 0 80 0 - 1158124 ep_pol 239936 0 Apr04 ? 00:00:03 ora_p001_ORCLCDB1

4 S oracle 79988 1 0 80 0 - 1162420 ep_pol 250708 5 Apr04 ? 00:00:03 ora_p002_ORCLCDB1

4 S oracle 79990 1 0 80 0 - 1156667 ep_pol 190632 1 Apr04 ? 00:00:01 ora_p003_ORCLCDB1

4 S oracle 79992 1 0 80 0 - 1155641 ep_pol 89196 2 Apr04 ? 00:00:01 ora_p004_ORCLCDB1

4 S oracle 79994 1 0 80 0 - 1155640 ep_pol 89692 3 Apr04 ? 00:00:01 ora_p005_ORCLCDB1

4 S oracle 79996 1 0 80 0 - 1155702 ep_pol 96076 4 Apr04 ? 00:00:00 ora_p006_ORCLCDB1

4 S oracle 79998 1 0 80 0 - 1155445 ep_pol 90600 7 Apr04 ? 00:00:01 ora_p007_ORCLCDB1

4 S oracle 80000 1 0 80 0 - 1155384 ep_pol 66496 1 Apr04 ? 00:00:00 ora_p008_ORCLCDB1

4 S oracle 80002 1 0 80 0 - 1155383 ep_pol 66444 5 Apr04 ? 00:00:00 ora_p009_ORCLCDB1

4 S oracle 80004 1 0 80 0 - 1155385 ep_pol 66408 5 Apr04 ? 00:00:00 ora_p00a_ORCLCDB1

4 S oracle 80006 1 0 80 0 - 1155383 ep_pol 66964 7 Apr04 ? 00:00:00 ora_p00b_ORCLCDB1

4 S oracle 80008 1 0 80 0 - 1155384 ep_pol 66400 2 Apr04 ? 00:00:00 ora_p00c_ORCLCDB1

4 S oracle 80010 1 0 80 0 - 1155383 ep_pol 66676 3 Apr04 ? 00:00:00 ora_p00d_ORCLCDB1

4 S oracle 80012 1 0 80 0 - 1155383 ep_pol 66152 7 Apr04 ? 00:00:00 ora_p00e_ORCLCDB1

4 S oracle 80014 1 0 80 0 - 1155384 ep_pol 66896 6 Apr04 ? 00:00:01 ora_p00f_ORCLCDB1

4 S oracle 80065 1 0 80 0 - 1155459 do_sem 86948 5 Apr04 ? 00:00:00 ora_qm02_ORCLCDB1

4 S oracle 80067 1 0 80 0 - 1155640 ep_pol 71920 3 Apr04 ? 00:00:08 ora_qm05_ORCLCDB1

4 S oracle 80069 1 0 80 0 - 1157277 do_sem 176416 7 Apr04 ? 00:00:00 ora_q002_ORCLCDB1

4 S oracle 80106 1 0 80 0 - 1161572 do_sem 251704 0 Apr04 ? 00:00:30 ora_cjq0_ORCLCDB1

4 S oracle 80108 1 0 80 0 - 1157221 pipe_w 123236 7 Apr04 ? 00:00:00 oracleORCLCDB1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S oracle 80226 1 0 80 0 - 1156245 pipe_w 90156 2 Apr04 ? 00:00:00 oracleORCLCDB1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S oracle 80335 1 0 80 0 - 1156285 pipe_w 92120 4 Apr04 ? 00:00:00 oracleORCLCDB1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S oracle 80665 1 0 80 0 - 1155383 do_sem 70704 6 Apr04 ? 00:00:00 ora_cl00_ORCLCDB1

4 S oracle 81129 1 0 80 0 - 1159088 pipe_w 110164 7 Apr04 ? 00:00:21 oracleORCLCDB1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S oracle 82206 1 0 80 0 - 1156324 pipe_w 101992 5 Apr04 ? 00:00:00 oracleORCLCDB1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S oracle 82448 1 0 80 0 - 1157308 do_sem 160692 4 Apr04 ? 00:00:00 ora_w006_ORCLCDB1

4 S oracle 84571 1 0 80 0 - 1156077 do_sem 128696 6 Apr04 ? 00:00:00 ora_w007_ORCLCDB1

4 S oracle 84579 1 0 80 0 - 1156077 do_sem 177076 5 Apr04 ? 00:00:00 ora_w008_ORCLCDB1

4 S oracle 84584 1 0 80 0 - 1156025 do_sem 122488 6 Apr04 ? 00:00:00 ora_w009_ORCLCDB1

4 S oracle 84653 1 0 80 0 - 1156595 do_sem 173684 2 Apr04 ? 00:00:00 ora_w00a_ORCLCDB1

4 S oracle 84693 1 0 80 0 - 1156069 do_sem 138852 5 Apr04 ? 00:00:00 ora_w00b_ORCLCDB1

4 S oracle 84700 1 0 80 0 - 1155822 do_sem 129800 3 Apr04 ? 00:00:00 ora_w00c_ORCLCDB1

4 S oracle 84714 1 0 80 0 - 1157308 do_sem 182900 1 Apr04 ? 00:00:00 ora_w00d_ORCLCDB1

4 S oracle 91474 1 0 80 0 - 1157219 pipe_w 122128 1 Apr04 ? 00:00:00 oracleORCLCDB1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S root 102277 0 0 80 0 - 2960 do_wai 2968 5 Apr04 pts/0 00:00:00 bash

4 S root 174609 102277 0 80 0 - 33374 poll_s 7152 4 00:14 pts/0 00:00:00 sudo -su oracle

4 S oracle 174610 174609 0 80 0 - 2960 wait_w 3076 6 00:14 pts/0 00:00:00 /bin/bash

4 S oracle 195304 1 0 80 0 - 1157119 do_sem 124688 2 13:46 ? 00:00:00 ora_q003_ORCLCDB1

4 S oracle 195398 1 0 80 0 - 1157295 do_sem 175388 1 13:46 ? 00:00:31 ora_gcr0_ORCLCDB1

4 S oracle 195400 1 0 80 0 - 1157300 do_sem 156536 7 13:46 ? 00:00:28 ora_gcr1_ORCLCDB1

4 S oracle 195402 1 0 80 0 - 1157210 do_sem 140444 2 13:46 ? 00:00:22 ora_gcr2_ORCLCDB1

4 S oracle 195405 1 0 80 0 - 1156071 do_sem 169196 2 13:46 ? 00:00:00 ora_w00f_ORCLCDB1

4 S oracle 195453 1 0 80 0 - 1160440 do_sem 176908 4 13:47 ? 00:00:00 ora_w00e_ORCLCDB1

4 S oracle 195462 1 0 80 0 - 1156029 do_sem 144544 7 13:47 ? 00:00:00 ora_w005_ORCLCDB1

4 S grid 195618 1 0 80 0 - 401273 do_sem 76528 0 13:47 ? 00:00:06 asm_r000_+ASM1

4 S oracle 196072 1 0 80 0 - 1168217 do_sem 416696 5 13:47 ? 00:00:07 ora_m000_ORCLCDB1

4 S oracle 196075 1 0 80 0 - 1176127 do_sem 502308 5 13:47 ? 00:00:08 ora_m001_ORCLCDB1

4 S oracle 196077 1 0 80 0 - 1168081 do_sem 294032 6 13:47 ? 00:00:07 ora_m002_ORCLCDB1

4 S oracle 207224 1 0 80 0 - 1176409 do_sem 549592 1 13:50 ? 00:00:08 ora_m003_ORCLCDB1

4 S oracle 240569 1 0 80 0 - 1157167 do_sem 190680 0 15:08 ? 00:00:04 ora_m004_ORCLCDB1

4 S root 296364 0 0 80 0 - 2959 do_wai 2968 0 17:21 pts/1 00:00:00 bash

4 S root 297568 296364 0 80 0 - 33374 poll_s 7336 3 17:24 pts/1 00:00:00 sudo -su grid

4 S grid 297570 297568 0 80 0 - 2960 do_wai 3064 3 17:24 pts/1 00:00:00 /bin/bash

4 S grid 309411 1 0 80 0 - 402230 pipe_w 93176 7 17:52 ? 00:00:00 oracle+ASM1_mmnl_orclcdb1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S grid 309693 1 0 80 0 - 401853 pipe_w 89768 6 17:53 ? 00:00:00 oracle+ASM1_crf (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

0 S grid 310051 24330 0 80 0 - 1094 hrtime 668 1 17:54 ? 00:00:00 sleep 30

0 S grid 310167 24513 0 80 0 - 1094 hrtime 736 1 17:54 ? 00:00:00 sleep 60

0 S root 310177 11575 0 80 0 - 1094 hrtime 692 6 17:54 ? 00:00:00 /bin/sleep 30

4 S root 310211 297570 0 80 0 - 32871 poll_s 7124 3 17:54 pts/1 00:00:00 sudo ps -Fel

4 D grid 310212 297570 0 80 0 - 1094 rpc_wa 660 4 17:54 pts/1 00:00:00 tee /oradata/proc.txt

4 R root 310213 310211 0 80 0 - 12936 - 3540 6 17:54 pts/1 00:00:00 ps -Fel

export TNS_ADMIN=$ORACLE_HOME/network/admin

sqlplus sys/sys@orclcdb as sysdba

SQL*Plus: Release 21.0.0.0.0 - Production on Wed Apr 5 18:56:50 2023

Version 21.3.0.0.0

Copyright (c) 1982, 2021, Oracle. All rights reserved.

Connected to:

Oracle Database 21c Enterprise Edition Release 21.0.0.0.0 - Production

Version 21.3.0.0.0

SQL> show parameter dispatchers

NAME TYPE VALUE

------------------------------------ ----------- ----------------------

dispatchers string (PROTOCOL=TCP) (SERVICE=ORCLCD

BXDB)

max_dispatchers integer

SQL> alter session set container=CDB$ROOT;

Session altered.

SQL> exec DBMS_XDB_CONFIG.SETHTTPSPORT(5500);

PL/SQL procedure successfully completed.

SQL> alter session set container=orclpdb;

Session altered.

SQL> exec DBMS_XDB_CONFIG.SETHTTPSPORT(5501);

PL/SQL procedure successfully completed.

Не забудьте заранее указать в манифесте kubernetes все нужные порты OEM для всех PDB.

Данное решение будет работать и в облачных кластерах kubernetes на виртуальных машинах провайдеров, если только managed kubernetes может блокировать настройки API server, kubelet, CRI.

Надеюсь, не забыл все необходимое.

Happy linux!

habr.com

habr.com

На сегодня первая в мире выкатка RAC в kubernetes и без docker.

uname -a

Linux r02 5.4.17-2136.300.7.el8uek.x86_64 #2 SMP Fri Oct 8 16:23:01 PDT 2021 x86_64 x86_64 x86_64 GNU/Linux

OEL 8.5 уже сертифицирована для Oracle RAC, 7.9 можно не устанавливать.

containerd --version

containerd github.com/containerd/containerd v1.6.4 212e8b6fa2f44b9c21b2798135fc6fb7c53efc16

runc --version

runc version 1.0.2

spec: 1.0.2-dev

go: go1.16.7

libseccomp: 2.5.1

Основные задачи настройки выкатки RAC:

- Создание и настройка подсетей в кластере kubernetes

- Настройка параметров:

- - ядра рабочего узла kubernetes

- - ядра контейнера RAC, namespaced и read only.

- Выбор и настройка конфигурации используемой RAC оперативной памяти

- Настройка общего хранилища RAC в kubernetes.

statefulset.yaml

################################################################################

# #

# Author: Serguei Nastassi itoracle@icloud.com #

# Created 01/03/2023 #

################################################################################

---

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: oracle-rac-213

spec:

serviceName: rdbms

podManagementPolicy: Parallel

updateStrategy:

type: RollingUpdate

replicas: 1

selector:

matchLabels:

app: oracle-rac-213

template:

metadata:

labels:

app: oracle-rac-213

annotations:

k8s.v1.cni.cncf.io/networks: '[

{

"name": "macvlan-conf",

"ips": ["172.16.1.150/24"]

},

{

"name": "macvlan-priv-conf",

"ips": ["192.168.17.150/24"]

}

]'

spec:

terminationGracePeriodSeconds: 300

securityContext:

sysctls:

- name: kernel.shmall

value: "2097152"

- name: kernel.sem

value: "250 32000 100 128"

- name: kernel.shmmax

value: "8589934592"

- name: kernel.shmmni

value: "4096"

containers:

- name: rdbms

image: cr.local:32424/container-registry.oracle.com/database/rac:21.3.0.0

resources:

requests:

memory: "16Gi"

limits:

memory: "16Gi"

securityContext:

privileged: true

capabilities:

add: ["SYS_NICE","SYS_RESOURCE","NET_ADMIN","AUDIT_CONTROL","AUDIT_WRITE","SYSLOG","SYS_TIME","SYS_RESOURCE","SYS_RAWIO","SYS_MODULE","SYS_CHROOT","SYS_BOOT","SYS_ADMIN","SETUID","SETGID","NET_BIND_SERVICE","CHOWN"]

runAsUser: 0

procMount: "Unmasked"

allowPrivilegeEscalation: true

envFrom:

- configMapRef:

name: oracle-rdbms-config

ports:

- containerPort: 1521

name: oracle-listener

- containerPort: 5500

name: oem-express

volumeDevices:

- name: ora-blk0

devicePath: /dev/asm_disk01

- name: ora-blk1

devicePath: /dev/asm_disk02

- name: ora-blk2

devicePath: /dev/asm_disk03

- name: ora-blk3

devicePath: /dev/asm_disk04

- name: ora-blk4

devicePath: /dev/asm_disk05

volumeMounts:

- name: oradata

mountPath: /oradata

- name: tmpfs

mountPath: /dev/shm

- name: hp

mountPath: /dev/hugepages

- name: cgroups

mountPath: /sys/fs/cgroup

# readOnly: true

- name: proc

mountPath: /hostproc

- name: boot

mountPath: /boot

readOnly: true

volumes:

- name: oradata

nfs:

server: "192.168.1.4"

path: /home/oracle-rac-213

- name: ora-blk0

persistentVolumeClaim:

claimName: nas-0-oracle-rac-213-0

- name: ora-blk1

persistentVolumeClaim:

claimName: nas-1-oracle-rac-213-0

- name: ora-blk2

persistentVolumeClaim:

claimName: nas-2-oracle-rac-213-0

- name: ora-blk3

persistentVolumeClaim:

claimName: nas-3-oracle-rac-213-0

- name: ora-blk4

persistentVolumeClaim:

claimName: nas-4-oracle-rac-213-0

- name: tmpfs

emptyDir:

medium: Memory

sizeLimit: 4Gi

- name: hp

hostPath:

path: /dev/hugepages

- name: cgroups

hostPath:

path: /sys/fs/cgroup

type: Directory

- name: proc

hostPath:

path: /home/hostproc

type: Directory

- name: boot

hostPath:

path: /boot

type: Directory

volumeClaimTemplates:

- metadata:

name: nas-0

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

- metadata:

name: nas-1

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

- metadata:

name: nas-2

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

- metadata:

name: nas-3

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

- metadata:

name: nas-4

spec:

accessModes:

- ReadWriteMany

volumeMode: Block

resources:

requests:

storage: 23Gi

Сначала создадим пространство имен:

---

apiVersion: v1

kind: Namespace

metadata:

name: oracle-rac-213

labels:

kubernetes.io/metadata.name: oracle-rac-213

pod-security.kubernetes.io/enforce: privileged

spec:

finalizers:

- kubernetes

Всвязи с отменой podSecurityPolicy с версии 1.23, часть настроек осуществляется в пространстве имен.

Создание сетей и адаптеров

Приватная и частная сети RAC, исторически требуется от 2 адаптеров, виртуальные тоже подходят, с меньшим количеством адаптеров работать не будет.По моему мнению любой CNI можно настроить на добавление дополнительных адаптеров контейнеру при запуске.

Для сокращения времени внедрения я использую готовое решение multus, одобренное cncf. При развертывании multus CNI в кластере kubernetes я советую обратить внимание на возможность развертывания только на узлах, где будут работать контейнеры RAC. Даже при отсутствии аннотаций в манифестах никакие контейнеры могут не запуститься по причине некорректных настроек после раскатки multus CNI. Сразу обратите внимание на файл /etc/cni/net.d/00-multus.conf

{ "cniVersion": "0.3.1", "name": "multus-cni-network", "type": "multus", "capabilities": {"portMappings": true}, "kubeconfig": "/etc/cni/net.d/multus.d/multus.kubeconfig", "delegates": [ { "cniVersion": "0.3.1", "name" ……

В будущих версиях containerd это может сработать и так, но сегодня при каждом запуске узла kubernetes этот файл обновляется и для корректной работы значение cniVersion должно быть 0.3.1.

Добавить определения сетей:

---

apiVersion: "k8s.cni.cncf.io/v1"

kind: NetworkAttachmentDefinition

metadata:

name: macvlan-conf

spec:

config: '{

"cniVersion": "0.3.1",

"plugins": [

{

"type": "macvlan",

"capabilities": { "ips": true },

"master": "cni0",

"mode": "bridge",

"ipam": {

"type": "static",

"routes": [

{

"dst": "0.0.0.0/0",

"gw": "172.16.1.1"

}

]

}

}

]

}'

---

apiVersion: "k8s.cni.cncf.io/v1"

kind: NetworkAttachmentDefinition

metadata:

name: macvlan-priv-conf

spec:

config: '{

"cniVersion": "0.3.1",

"plugins": [

{

"type": "macvlan",

"capabilities": { "ips": true },

"master": "enp2s0f1",

"mtu": 1500,

"mode": "bridge",

"ipam": {

"type": "static"

}

}

]

}'

Я специально написал mtu 1500 для приватной сети, зная, что требуются jumbo packets с mtu 9000 и мы получим предупреждение при развертывании grid в журналах. Ничего страшного в этом нет, просто для этой настройки потребуется еще немало работы, которая не входит в текущие планы. Вполне может оказаться, что 20% ускорения при использовании jumbo packets не скажется на общей производительности.

spec. securityContext:sysctls: именно здесь можно объявить для использования в контейнере часть параметров ядра, остальные можно установить на уровне рабочего узла kubernetes.

Для этого используется featureGates на рабочем узле, в файл /var/lib/kubelet/config.yaml добавить строку:

allowedUnsafeSysctls: [kernel.shm*, kernel.sem, net.*]

В файл /etc/kubernetes/manifests/kube-apiserver.yaml добавить

--feature-gates=ProcMountType=true

API server kubernetes перезапустится в течение нескольких минут, API ресурсы кластера будут недоступны. На этом пункте важно понимать что и зачем вы делаете, иначе вы можете потерять свой кластер kubernetes.

Перезапустить kubelet, swap до этого момента должен быть все еще отключен.

Можно ничего этого не делать, просто все sysctl на уровне хоста добавить в /etc/sysctl.conf и sysctl -p, вопрос перфекционизма. Все требуемое официальной документацией Oracle туда тоже следует непременно добавить.

Для ускорения загрузки образа (20Gi) лучше настроить любой локальный реестр образов.

Потом

podman pull container-registry.oracle.com/database/rac:21.3.0.0

podman push --tls-verify=false <image> docker-service.docker-registry:5000/container-registry.oracle.com/database/rac:21.3.0.0

Для настройки mirror registry в config.toml добавьте имя и порт вашего реестра:

[plugins."io.containerd.grpc.v1.cri".registry.configs]

[plugins."io.containerd.grpc.v1.cri".registry.configs."cr.local:32424"]

[plugins."io.containerd.grpc.v1.cri".registry.configs."cr.local:32424".tls]

insecure_skip_verify = true

[plugins."io.containerd.grpc.v1.cri".registry.headers]

[plugins."io.containerd.grpc.v1.cri".registry.mirrors]

[plugins."io.containerd.grpc.v1.cri".registry.mirrors."cr.local:32424"]

endpoint = ["https://cr.local:32424"]

В этом примере podman работает в своем контейнере и порт хранилища используется в сети кластера kubernetes, а containerd работает с сетью хоста, поэтому мы видим порт из сервиса деплоймента podman в kubernetes.

securityContext:

privileged: true

Здесь нет никакой ошибки, именно на уровне контейнера и объявляется второй блок securityContext. При сравнении с официальной docker конфигурацией Oracle выясняется существенная разница в работе docker и kubernetes.

Настройка параметров оперативной памяти

Общий объем оперативной памяти на описываемом стенде не очень большой - 20Gb, рекомендованный минимальный объем 16Gb для пода кажется нормальным. Также на узле обязательно работают kube-proxy, flannel, multus, container registry необязательно, экономит время.Очень важно определиться на каком оборудовании можно и нужно использовать huge pages. По моему личному мнению, основанному на рекомендациях Oracle, официально определенную величину vm.nr_hugepages=16384 не стоит использовать на серверах с объемом физической оперативной памяти менее 64Gb. Попробовать можно, скорее всего база Oracle не стартует. Просто не используйте ее:

sysctl vm.nr_hugepages=0

Сервер БД Oracle сам переключится на использование обычных страниц, которых должно быть достаточно. Тогда следует коррелировать размер SGA и выделенной области /dev/shm. Тут они 3.8Gb и 4Gb соответственно.

Не забудьте отключить transparent huge pages во всех случаях:

sudo echo never > /sys/kernel/mm/transparent_hugepage/enabled

Лучше это сделать на уровне GRUB заранее.

Подготовка к запуску install grid infrastructure

В common_scripts создайте sh файл:# Init script

sudo mv /etc/ntp.conf /etc/ntp.conf-

sudo ln -s /oradata/.secrets/common_os_pwdfile.enc /run/secrets/common_os_pwdfile.enc

sudo ln -s /oradata/.secrets/pwd.key /run/secrets/pwd.key

sudo mount --bind /hostproc/net/core /proc/sys/net/core

sudo echo 950000 > /sys/fs/cgroup/cpu/system.slice/cpu.rt_runtime_us

sudo sysctl kernel.sched_rt_runtime_us=-1

sudo sed -i 's/134217728$/8388608/' /etc/security/limits.conf

sudo yum -y install chrony

sudo systemctl start chronyd

Переименование файла ntp.conf, чтобы избежать ошибки cvu. Непонятно, зачем он оказался в этом образе.

Шифрование начального пароля и размещение закрытого ключа описано в документации Oracle, просто поместите те файлы сюда.

Далее идет трюк на грани фола. Невозможно пока отобразить все нужные параметры ядра, чтобы cvu check был чистым, скопируйте в обычную файловую систему участок

sudo cp -r /proc/sys/net /home/<…>

В этом командном файле mount --bind успешно подмонтирует этот кусочек в /proc контейнера и мы не увидим ни одной ошибки cvu ни журналов контейнера.

kernel.sched_rt_runtime_us=-1 на этой «-1» тут, честно говоря все и держится

Система должна быть загружена со значением DefaultCPUAccounting=no в /etc/systemd/system.conf Иначе не заработает realtime в контейнере.

/etc/security/limits.conf содержит нереальное значение memlock 128Gb, база запускаться не будет, поэтому для системы 20Gb на все выделим по 8Gb на ASM и 8Gb на Oracle.

Chronyd пришел на смену ntp и он тут стартует.

Данный файл следует выполнить в первые 60 секунд работы контейнера, для этого там время и выделено.

kubectl -n oracle-rac-213 exec -it oracle-rac-213-0 -- bash /oradata/scripts/ini.sh

Разделяемое Хранилище

Разверните 1 или более nfs серверов для раздачи каталога с файлами хранилища. При наличии специализированного NAS оборудования тут можно много пропустить.Подготовьте 2 или более файла на nfs серверах согласно документации Oracle.

Я использую немного другое, но очень быстрое решение:

cd /home/oracle-rac-213/

sudo fallocate -z -o 0 -l 23G asm_disk01.img

sudo fallocate -z -o 0 -l 23G asm_disk02.img

sudo fallocate -z -o 0 -l 23G asm_disk03.img

sudo fallocate -z -o 0 -l 23G asm_disk04.img

sudo fallocate -z -o 0 -l 23G asm_disk05.img

Наличие нулевых блоков хранится в метаданных файловой системы.

На рабочем узле kubernetes смонтируйте шару:

mkdir -p /mnt/ora

mount -t nfs 192.168.1.4:/home/oracle-rac-213 /mnt/ora

Смонтируйте каждый файл как устройство:

losetup -f /mnt/ora/asm_disk01.img

… И т.д.

Теперь можно объявить все persistent volumes:

---

kind: PersistentVolume

apiVersion: v1

metadata:

name: nas-0

spec:

volumeMode: Block

capacity:

storage: 23Gi

local:

path: /dev/loop0

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

nodeAffinity:

required:

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/hostname

operator: In

values:

- r02

Все объявить надо.

Persistent volume claims у нас объявлены в statefulset manifest.

Настройки

---apiVersion: v1

kind: ConfigMap

metadata:

name: oracle-rdbms-config

labels:

app: oracle-rac-213

data:

# IGNORE_CVU_CHECKS: "true"

#

CLUSTER_NAME: "ora-213"

# DHCP_CONF: "TRUE"

NODE_VIP: "172.16.1.160"

VIP_HOSTNAME: "oracle-rac-213-0-v"

PUBLIC_IP: "172.16.1.150"

PUBLIC_HOSTNAME: "oracle-rac-213-0"

SCAN_NAME: "ora-scan"

# SCAN_IP: "172.16.1.70"

PRIV_IP: "192.168.17.150"

PRIV_HOSTNAME: "oracle-rac-213-0-p"

#

# CMAN_IP: "172.16.1.15"

# CMAN_HOSTNAME: "cman-1"

#

COMMON_OS_PWD_FILE: "common_os_pwdfile.enc"

PWD_KEY: "pwd.key"

#

DOMAIN: "oracle-rac-213.svc.cluster.local"

# DNS_SEARCH: "10.96.0.10"

# DNS_SERVERS: "192.168.1.1" #"10.96.0.10"

# DEFAULT_GATEWAY: "172.16.1.1" # within container

ASM_DEVICE_LIST: "/dev/asm_disk01,/dev/asm_disk02,/dev/asm_disk03,/dev/asm_disk04,/dev/asm_disk05"

ASM_DISCOVERY_DIR: "/dev"

# GRID_RESPONSE_FILE: "grid_sample.rsp"

# DBCA_RESPONSE_FILE: "dbca_sample.rsp"

OP_TYPE: "INSTALL"

Не указываю явно DNS сервер, нормальный режим работы Oracle, он будет ориентироваться на resolv.conf, далее cluster dns. Главное в этой цепочке указать соответствие имен хостов из этого списка и их адресов, для SCAN указать все 3 адреса 172.16.1.70 - 172.16.1.72. Я использовал dns сервер из внешнего к кластеру kubernetes сетевого домена, поэтому пришлось указывать все 2 раза с доменом и без. Имя домена в контейнере образуется по правилам kubernetes: oracle-rac-213.svc.cluster.local

Включение swap

sudo fallocate -l 32G /swap.imgsudo chmod 600 /swap.img

sudo mkswap /swap.img

sudo swapon /swap.img

Запуск и мониторинг

Примените все манифесты, начиная с создания пространства имен и заканчивая statefulset.Я использую Argocd:

Основные компоненты

Сервисы для доступа к БД и OEM можно получить в моем репозитории https://github.com/itoracl/oracle-rac-213, как и все вышеприведенные манифесты.

Для вашей системы потребуется дополнительная настройка доступа к БД извне кластера. CMAN это опция и его можно и нужно настроить дополнительно.

Примерно через час видим полный good luck screen

Выполним внутри контейнера:

[grid@oracle-rac-213-0 ~] $ crsctl check crs

CRS-4638: Oracle High Availability Services is online

CRS-4537: Cluster Ready Services is online

CRS-4529: Cluster Synchronization Services is online

CRS-4533: Event Manager is online

[grid@oracle-rac-213-0 ~] $ crsctl status resource -w "TYPE co ’ora’" -t

--------------------------------------------------------------------------------

Name Target State Server State details

--------------------------------------------------------------------------------

Local Resources

--------------------------------------------------------------------------------

ora.LISTENER.lsnr

ONLINE ONLINE oracle-rac-213-0 STABLE

ora.chad

ONLINE ONLINE oracle-rac-213-0 STABLE

ora.net1.network

ONLINE ONLINE oracle-rac-213-0 STABLE

ora.ons

ONLINE ONLINE oracle-rac-213-0 STABLE

--------------------------------------------------------------------------------

Cluster Resources

--------------------------------------------------------------------------------

ora.ASMNET1LSNR_ASM.lsnr(ora.asmgroup)

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.DATA.dg(ora.asmgroup)

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.LISTENER_SCAN1.lsnr

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.LISTENER_SCAN2.lsnr

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.LISTENER_SCAN3.lsnr

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.asm(ora.asmgroup)

1 ONLINE ONLINE oracle-rac-213-0 Started,STABLE

ora.asmnet1.asmnetwork(ora.asmgroup)

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.cdp1.cdp

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.cdp2.cdp

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.cdp3.cdp

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.cvu

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.oracle-rac-213-0.vip

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.orclcdb.db

1 ONLINE ONLINE oracle-rac-213-0 Open,HOME=/u01/app/o

racle/product/21.3.0

/dbhome_1,STABLE

ora.orclcdb.orclpdb.pdb

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.qosmserver

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.scan1.vip

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.scan2.vip

1 ONLINE ONLINE oracle-rac-213-0 STABLE

ora.scan3.vip

1 ONLINE ONLINE oracle-rac-213-0 STABLE

--------------------------------------------------------------------------------

Как там чувствуют себя процессы:

[grid@oracle-rac-213-0 ~]$ sudo ps -Fel

F S UID PID PPID C PRI NI ADDR SZ WCHAN RSS PSR STIME TTY TIME CMD

4 S root 1 0 0 80 0 - 18687 ep_pol 7172 5 Apr04 ? 00:00:04

4 S root 19 1 0 80 0 - 12093 ep_pol 14640 1 Apr04 ? 00:00:01 /usr/lib/systemd/systemd-journald

4 S dbus 48 1 0 80 0 - 14526 ep_pol 4516 2 Apr04 ? 00:00:01 /usr/bin/dbus-daemon --system --address=systemd: --nofork --nopidfile --systemd-activation

5 S rpc 49 1 0 80 0 - 17317 poll_s 3368 6 Apr04 ? 00:00:00 /sbin/rpcbind -w

5 S root 56 1 0 80 0 - 22881 ep_pol 2720 5 Apr04 ? 00:00:00 /usr/sbin/gssproxy -D

4 S root 72 1 0 80 0 - 6656 ep_pol 3124 0 Apr04 ? 00:00:00 /usr/lib/systemd/systemd-logind

4 S root 73 1 0 80 0 - 13223 hrtime 5064 5 Apr04 ? 00:00:00 /usr/sbin/smartd -n -q never

4 S root 81 1 0 80 0 - 5678 hrtime 2756 5 Apr04 ? 00:00:00 /usr/sbin/crond -n

4 S root 214 1 0 80 0 - 28237 poll_s 8024 7 Apr04 ? 00:00:00 /usr/sbin/sshd -D

4 S root 219 1 0 80 0 - 27922 wait_w 2232 2 Apr04 tty1 00:00:00 /sbin/agetty --noclear tty1 linux

5 S chrony 367 1 0 80 0 - 25127 poll_s 3152 1 Apr04 ? 00:00:00 /usr/sbin/chronyd

4 S root 11575 1 0 80 0 - 2958 do_wai 2868 1 Apr04 ? 00:00:01 /bin/sh /etc/init.d/init.tfa run >/dev/null 2>&1 </dev/null

4 S root 12746 1 0 80 0 - 2959 pipe_w 2760 5 Apr04 ? 00:00:00 /bin/sh /etc/init.d/init.ohasd run >/dev/null 2>&1 </dev/null

4 S root 20700 1 0 80 0 - 817029 futex_ 131196 3 Apr04 ? 00:02:07 /u01/app/21.3.0/grid/bin/ohasd.bin reboot BLOCKING_STACK_LOCALE_OHAS=AMERICAN_AMERICA.WE8ISO8859P1

4 S root 20801 1 0 80 0 - 509019 futex_ 114976 2 Apr04 ? 00:01:09 /u01/app/21.3.0/grid/bin/orarootagent.bin

4 S grid 20889 1 0 80 0 - 424096 futex_ 102324 7 Apr04 ? 00:01:46 /u01/app/21.3.0/grid/bin/oraagent.bin

4 S grid 20912 1 0 80 0 - 107668 poll_s 34940 4 Apr04 ? 00:00:39 /u01/app/21.3.0/grid/bin/mdnsd.bin

4 S grid 20914 1 0 80 0 - 231782 ep_pol 53252 5 Apr04 ? 00:01:30 /u01/app/21.3.0/grid/bin/evmd.bin

4 S grid 20947 1 0 80 0 - 279095 hrtime 46768 0 Apr04 ? 00:00:45 /u01/app/21.3.0/grid/bin/gpnpd.bin

4 S grid 20999 20914 0 80 0 - 110191 poll_s 39388 3 Apr04 ? 00:00:40 /u01/app/21.3.0/grid/bin/evmlogger.bin -o /u01/app/21.3.0/grid/log/[HOSTNAME]/evmd/evmlogger.info -l /u01/app/21.3.0/grid/log/[HOSTNAME]/e

vmd/evmlogger.log

4 S grid 21018 1 0 80 0 - 219524 hrtime 73508 1 Apr04 ? 00:01:34 /u01/app/21.3.0/grid/bin/gipcd.bin

4 S root 21060 1 0 -40 - - 295798 futex_ 159344 1 Apr04 ? 00:00:42 /u01/app/21.3.0/grid/bin/cssdmonitor

4 S root 21062 1 0 30 - - 415971 hrtime 184224 1 Apr04 ? 00:03:28 /u01/app/21.3.0/grid/bin/osysmond.bin

4 S root 21096 1 0 -40 - - 329843 futex_ 165852 4 Apr04 ? 00:00:41 /u01/app/21.3.0/grid/bin/cssdagent

4 S grid 21113 1 0 -40 - - 550843 futex_ 210708 7 Apr04 ? 00:01:19 /u01/app/21.3.0/grid/bin/onmd.bin -S 1

4 S grid 21115 1 0 -40 - - 276213 futex_ 163228 0 Apr04 ? 00:01:17 /u01/app/21.3.0/grid/bin/ocssd.bin -S 1

4 S root 21469 1 0 80 0 - 247004 futex_ 44256 2 Apr04 ? 00:01:36 /u01/app/21.3.0/grid/bin/octssd.bin reboot

4 S root 21541 1 0 80 0 - 278565 poll_s 246248 7 Apr04 ? 00:01:18 /u01/app/21.3.0/grid/bin/ologgerd -M

4 S grid 21709 1 0 80 0 - 401337 do_sem 89704 5 Apr04 ? 00:00:01 asm_pmon_+ASM1

4 S grid 21715 1 0 80 0 - 401338 do_sem 75892 0 Apr04 ? 00:00:01 asm_clmn_+ASM1

4 S grid 21720 1 0 80 0 - 401338 do_sem 78420 3 Apr04 ? 00:00:03 asm_psp0_+ASM1

4 S grid 21724 1 0 58 - - 401338 hrtime 75524 0 Apr04 ? 00:03:11 asm_vktm_+ASM1

4 S grid 21730 1 0 80 0 - 405519 do_sem 94880 7 Apr04 ? 00:00:02 asm_gen0_+ASM1

4 S grid 21754 1 0 80 0 - 401337 do_sem 74076 6 Apr04 ? 00:00:00 asm_mman_+ASM1

4 S grid 21760 1 0 80 0 - 409138 poll_s 118480 4 Apr04 ? 00:00:23 asm_lmon_+ASM1

4 S grid 21764 1 0 80 0 - 431391 do_sem 80028 7 Apr04 ? 00:00:02 asm_gen1_+ASM1

4 S grid 21766 1 0 80 0 - 401338 do_sem 74572 7 Apr04 ? 00:00:00 asm_gen2_+ASM1

4 S grid 21768 1 0 80 0 - 434974 do_sem 104712 3 Apr04 ? 00:00:43 asm_lms0_+ASM1

4 S grid 21773 1 0 80 0 - 401338 do_sem 76280 0 Apr04 ? 00:00:00 asm_vosd_+ASM1

4 S grid 21775 1 0 80 0 - 403062 poll_s 92640 6 Apr04 ? 00:00:13 asm_diag_+ASM1

4 S grid 21781 1 0 80 0 - 404921 poll_s 90304 2 Apr04 ? 00:00:01 asm_ping_+ASM1

4 S grid 21790 1 0 80 0 - 401338 do_sem 77572 3 Apr04 ? 00:00:03 asm_pman_+ASM1

4 S grid 21793 1 0 80 0 - 405801 poll_s 117228 7 Apr04 ? 00:00:42 asm_dia0_+ASM1

4 S grid 21798 1 0 80 0 - 408782 poll_s 96676 1 Apr04 ? 00:00:20 asm_lmd0_+ASM1

4 S grid 21801 1 0 80 0 - 403500 poll_s 108768 6 Apr04 ? 00:00:24 asm_lmhb_+ASM1

4 S grid 21809 1 0 80 0 - 401338 do_sem 77852 2 Apr04 ? 00:00:00 asm_lck1_+ASM1

4 S grid 21811 1 0 80 0 - 402962 do_sem 96240 3 Apr04 ? 00:00:00 asm_dbw0_+ASM1

4 S grid 21813 1 0 58 - - 401549 do_sem 96624 7 Apr04 ? 00:00:01 asm_lgwr_+ASM1

4 S grid 21817 1 0 80 0 - 401337 do_sem 99256 4 Apr04 ? 00:00:02 asm_ckpt_+ASM1

4 S grid 21819 1 0 80 0 - 401338 do_sem 75244 3 Apr04 ? 00:00:00 asm_smon_+ASM1

4 S grid 21821 1 0 80 0 - 403134 ep_pol 84064 6 Apr04 ? 00:00:00 asm_lreg_+ASM1

4 S grid 21823 1 0 80 0 - 482480 do_sem 90184 6 Apr04 ? 00:00:02 asm_bg00_+ASM1

4 S grid 21827 1 0 80 0 - 401338 do_sem 75388 6 Apr04 ? 00:00:00 asm_pxmn_+ASM1

4 S grid 21831 1 0 80 0 - 406147 do_sem 106944 3 Apr04 ? 00:00:02 asm_rbal_+ASM1

4 S grid 21839 1 0 80 0 - 406054 do_sem 101380 3 Apr04 ? 00:00:03 asm_gmon_+ASM1

4 S grid 21845 1 0 80 0 - 405160 do_sem 89820 3 Apr04 ? 00:00:01 asm_mmon_+ASM1

4 S grid 21848 1 0 80 0 - 401338 do_sem 98088 6 Apr04 ? 00:00:09 asm_mmnl_+ASM1

4 S grid 21853 1 0 80 0 - 482272 do_sem 84680 6 Apr04 ? 00:00:02 asm_bg01_+ASM1

4 S grid 21861 1 0 80 0 - 401449 do_sem 81956 0 Apr04 ? 00:00:34 asm_imr0_+ASM1

4 S grid 21867 1 0 80 0 - 401272 do_sem 77648 2 Apr04 ? 00:00:05 asm_scm0_+ASM1

4 S grid 21881 1 0 80 0 - 401770 poll_s 88032 5 Apr04 ? 00:00:02 asm_lck0_+ASM1

4 S grid 21931 1 0 80 0 - 401793 do_sem 101820 2 Apr04 ? 00:01:07 asm_gcr0_+ASM1

4 S grid 23369 1 0 80 0 - 402095 pipe_w 88824 6 Apr04 ? 00:00:02 asm_asmb_+ASM1

4 S grid 23377 1 0 80 0 - 405882 do_sem 93612 5 Apr04 ? 00:00:04 oracle+ASM1_asmb_+asm1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S root 23386 1 0 80 0 - 1113981 futex_ 159168 3 Apr04 ? 00:03:59 /u01/app/21.3.0/grid/bin/crsd.bin reboot

4 S grid 23599 1 0 80 0 - 402364 pipe_w 105516 2 Apr04 ? 00:00:01 oracle+ASM1_ocr (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S root 24050 1 0 80 0 - 1467664 futex_ 371004 3 Apr04 ? 00:03:10 /opt/oracle.ahf/jre/bin/java -server -Xms128m -Xmx256m -Djava.awt.headless=true -Ddisable.checkForUpdate=true -XX:HeapDumpPath=/u01/app/gr

id/oracle.ahf/data/oracle-rac-213-0/diag/tfa oracle.rat.tfa.TFAMain /opt/oracle.ahf/tfa

4 S grid 24330 1 0 80 0 - 2429 do_wai 2748 1 Apr04 ? 00:00:06 /bin/sh ./OSWatcher.sh 30 48 NONE /u01/app/grid/oracle.ahf/data/repository/suptools/oracle-rac-213-0/oswbb/grid/archive

4 S grid 24513 24330 0 80 0 - 2395 do_wai 2580 0 Apr04 ? 00:00:03 /bin/sh ./OSWatcherFM.sh 48 /u01/app/grid/oracle.ahf/data/repository/suptools/oracle-rac-213-0/oswbb/grid/archive

4 S root 25884 1 0 80 0 - 326980 futex_ 90992 0 Apr04 ? 00:05:35 /u01/app/21.3.0/grid/bin/orarootagent.bin

4 S grid 25917 1 0 80 0 - 716267 futex_ 139864 2 Apr04 ? 00:03:07 /u01/app/21.3.0/grid/bin/oraagent.bin

4 S grid 25942 1 0 80 0 - 35739 ep_pol 23928 7 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr ASMNET1LSNR_ASM -no_crs_notify -inherit

4 S grid 26001 1 0 80 0 - 402181 pipe_w 102188 7 Apr04 ? 00:00:00 oracle+ASM1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

5 S grid 26143 1 0 80 0 - 6873 do_wai 580 5 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/opmn/bin/ons -d

5 S grid 26144 26143 0 80 0 - 75513 futex_ 11328 2 Apr04 ? 00:00:01 /u01/app/21.3.0/grid/opmn/bin/ons -d

4 S grid 26279 1 0 80 0 - 68666 ep_pol 23956 2 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr LISTENER_SCAN1 -no_crs_notify -inherit

4 S grid 26302 1 0 80 0 - 68666 ep_pol 23992 1 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr LISTENER_SCAN2 -no_crs_notify -inherit

4 S grid 26323 1 0 80 0 - 68667 ep_pol 24184 6 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr LISTENER_SCAN3 -no_crs_notify -inherit

4 S grid 26395 1 0 80 0 - 208633 futex_ 55360 4 Apr04 ? 00:00:45 /u01/app/21.3.0/grid/bin/scriptagent.bin

4 S grid 26625 1 0 80 0 - 1288136 futex_ 420932 4 Apr04 ? 00:04:04 /u01/app/21.3.0/grid/jdk/bin/java -server -Xms128M -Xmx512M -Djava.awt.headless=true -Ddisable.checkForUpdate=true -Djava.security.propert

ies=/u01/app/grid/crsdata/oracle-rac-213-0/qos/conf/qos.security -Djdk.tls.client.protocols="TLSv1.2,TLSv1.3" -Dhttps.protocols="TLSv1.2,TLSv1.3" -Djava.util.logging.config.file=/u01/app/grid/crsdata/oracle-rac-213-0/qos/conf/l

ogging.properties -Djava.util.logging.manager=org.apache.juli.ClassLoaderLogManager -DTRACING.ENABLED=false -Djava.rmi.server.hostname=oracle-rac-213-0 -Doracle.http.port=8888 -Doracle.jmx.port=8895 -Doracle.tls.enabled=false -

Doracle.jwc.tls.http.enabled=true -Doracle.wlm.dbwlm.always_on=true -Djava.security.manager -Djava.security.policy=/u01/app/grid/crsdata/oracle-rac-213-0/qos/conf/catalina.policy -Djava.security.egd=file:/dev/urandom -XX

elGCThreads=2 -Doracle.rest.enabled=true -Doracle.jmx.enabled=true -Dcatalina.home=/u01/app/21.3.0/grid/tomcat -Dcatalina.base=/u01/app/grid/crsdata/oracle-rac-213-0/qos -Djava.io.tmpdir=/u01/app/grid/crsdata/oracle-rac-213-0/q

os/temp -Doracle.home=/u01/app/21.3.0/grid -Doracle.jwc.mode=CLUSTERWARE -classpath /u01/app/21.3.0/grid/jlib/cryptoj.jar:/u01/app/21.3.0/grid/jlib/oraclepki.jar:/u01/app/21.3.0/grid/jlib/osdt_core.jar:/u01/app/21.3.0/grid/jlib

/osdt_cert.jar:/u01/app/21.3.0/grid/tomcat/lib/tomcat-juli.jar:/u01/app/21.3.0/grid/tomcat/lib/bootstrap.jar:/u01/app/21.3.0/grid/jlib/jwc-logging.jar org.apache.catalina.startup.Bootstrap start

0 S grid 27153 1 0 80 0 - 1066039 futex_ 192716 4 Apr04 ? 00:01:12 /u01/app/21.3.0/grid/jdk/bin/java -server -Xms30M -Xmx1024M -Djava.awt.headless=true -Ddisable.checkForUpdate=true -DTRACING.ENABLED=false

-XX

1.3.0/grid/jlib/srvmhas.jar:/u01/app/21.3.0/grid/jlib/srvmasm.jar:/u01/app/21.3.0/grid/jlib/netcfg.jar:/u01/app/21.3.0/grid/jdbc/lib/ojdbc8.jar:/u01/app/21.3.0/grid/ucp/lib/ucp.jar:/u01/app/21.3.0/grid/jlib/fte.jar:/u01/app/21.

3.0/grid/jlib/jai_core.jar:/u01/app/21.3.0/grid/jlib/mlibwrapper_jai.jar:/u01/app/21.3.0/grid/jlib/vecmath.jar:/u01/app/21.3.0/grid/jlib/jai_codec.jar:/u01/app/21.3.0/grid/jlib/jh.jar:/u01/app/21.3.0/grid/jlib/lucene-core-8.1.1

.jar oracle.cha.server.CHADDriver

4 S grid 27422 1 0 80 0 - 402146 pipe_w 96552 5 Apr04 ? 00:00:00 oracle+ASM1 (DESCRIPTION=(LOCAL=YES)(ADDRESS=(PROTOCOL=beq)))

4 S grid 27711 1 0 80 0 - 313505 futex_ 51048 6 Apr04 ? 00:01:03 /u01/app/21.3.0/grid/bin/crscdpd.bin

4 S grid 27769 1 0 80 0 - 313505 futex_ 49432 1 Apr04 ? 00:01:03 /u01/app/21.3.0/grid/bin/crscdpd.bin

4 S grid 28015 1 0 80 0 - 313505 futex_ 49776 6 Apr04 ? 00:01:02 /u01/app/21.3.0/grid/bin/crscdpd.bin

4 S grid 28744 1 0 80 0 - 74214 ep_pol 28552 4 Apr04 ? 00:00:00 /u01/app/21.3.0/grid/bin/tnslsnr LISTENER -no_crs_notify -inherit

4 S grid 28788 1 0 80 0 - 824812 futex_ 74460 0 Apr04 ? 00:00:55 /u01/app/21.3.0/grid/jdk/bin/java -Xms128M -Xmx384M -classpath /u01/app/21.3.0/grid/jdk/jre/lib/rt.jar:/u01/app/21.3.0/grid/jdk/jre/lib/i1

8n.jar:/u01/app/21.3.0/grid/jlib/jagent.jar:/u01/app/21.3.0/grid/jlib/srvm.jar: -Dora.jagent.conf=conf/orajagent.conf oracle.jagent.core.OraJavaAgentDriver

4 S oracle 79326 1 0 80 0 - 377232 futex_ 107320 2 Apr04 ? 00:01:05 /u01/app/21.3.0/grid/bin/oraagent.bin

4 S oracle 79418 1 0 80 0 - 1155448 do_sem 77140 2 Apr04 ? 00:00:01 ora_pmon_ORCLCDB1

4 S oracle 79422 1 0 80 0 - 1155448 do_sem 74232 7 Apr04 ? 00:00:00 ora_clmn_ORCLCDB1

4 S oracle 79426 1 0 80 0 - 1155482 do_sem 74196 6 Apr04 ? 00:00:03 ora_psp0_ORCLCDB1

4 S oracle 79430 1 0 80 0 - 1155939 ep_pol 87036 3 Apr04 ? 00:00:32 ora_ipc0_ORCLCDB1

4 S oracle 79434 1 0 58 - - 1155448 hrtime 72708 5 Apr04 ? 00:02:51 ora_vktm_ORCLCDB1

4 S oracle 79440 1 0 80 0 - 1162043 do_sem 147920 0 Apr04 ? 00:00:01 ora_gen0_ORCLCDB1

4 S oracle 79444 1 0 80 0 - 1155449 do_sem 759988 5 Apr04 ? 00:00:01 ora_mman_ORCLCDB1

4 S oracle 79450 1 0 80 0 - 1163850 ep_pol 236596 3 Apr04 ? 00:00:19 ora_lmon_ORCLCDB1

4 S oracle 79454 1 0 80 0 - 1186455 do_sem 100184 4 Apr04 ? 00:00:04 ora_gen1_ORCLCDB1

4 S oracle 79456 1 0 80 0 - 1161013 do_sem 125000 7 Apr04 ? 00:00:00 ora_gen2_ORCLCDB1

4 S oracle 79458 1 0 80 0 - 1212565 do_sem 215368 0 Apr04 ? 00:00:46 ora_lms0_ORCLCDB1

4 S oracle 79460 1 0 80 0 - 1212564 do_sem 216680 0 Apr04 ? 00:00:46 ora_lms1_ORCLCDB1

4 S oracle 79466 1 0 80 0 - 1155449 do_sem 73284 1 Apr04 ? 00:00:00 ora_vosd_ORCLCDB1

4 S oracle 79468 1 0 80 0 - 1157178 ep_pol 89068 0 Apr04 ? 00:00:09 ora_diag_ORCLCDB1

4 S oracle 79470 1 0 80 0 - 1186711 do_sem 109432 0 Apr04 ? 00:00:00 ora_ofsd_ORCLCDB1

4 S oracle 79477 1 0 80 0 - 1161059 do_sem 232032 5 Apr04 ? 00:00:07 ora_dbrm_ORCLCDB1

4 S oracle 79479 1 0 80 0 - 1155449 do_sem 74336 1 Apr04 ? 00:00:14 ora_vkrm_ORCLCDB1

4 S oracle 79481 1 0 80 0 - 1161081 ep_pol 92648 4 Apr04 ? 00:00:00 ora_ping_ORCLCDB1

4 S oracle 79483 1 0 80 0 - 1157588 ep_pol 116544 7 Apr04 ? 00:00:01 ora_svcb_ORCLCDB1

4 S oracle 79488 1 0 80 0 - 1155449 do_sem 72556 1 Apr04 ? 00:00:00 ora_acms_ORCLCDB1

4 S oracle 79492 1 0 80 0 - 1155450 do_sem 74500 2 Apr04 ? 00:00:03 ora_pman_ORCLCDB1

4 S oracle 79495 1 0 80 0 - 1159403 ep_pol 111588 2 Apr04 ? 00:00:29 ora_dia0_ORCLCDB1

4 S oracle 79498 1 0 80 0 - 1155988 ep_pol 101548 3 Apr04 ? 00:00:16 ora_lmd0_ORCLCDB1

4 S oracle 79502 1 0 80 0 - 1155960 ep_pol 98636 0 Apr04 ? 00:00:15 ora_lmd1_ORCLCDB1

4 S oracle 79504 1 0 80 0 - 1155448 do_sem 73632 1 Apr04 ? 00:00:00 ora_rms0_ORCLCDB1