Развернутые ответы на вопросы открытой предметной области (Open-domain Long-form Question Answering, LFQA) — это одна из фундаментальных задач в обработке естественного языка (Natural Language Processing, NLP), которая включает в себя извлечение документов, относящихся к заданному вопросу, и их использование для генерации подробного ответа, доходящего до абзаца в длину. Несмотря на то что в последнее время был достигнут значительный прогресс в области ответов на фактоидные вопросы (QA) открытой предметной области, для которых достаточно короткой фразы или сущности, гораздо меньше было сделано в области ответов на вопросы в развернутой форме. Тем не менее, LFQA является важной задачей, особенно потому, что она предоставляет тестовую площадку для измерения фактологичности генеративных текстовых моделей. Но действительно ли существующие тесты и метрики подходят для дальнейшего развития технологий LFQA?

В статье «Hurdles to Progress in Long-form Question Answering» (появится на конференции NAACL 2021) авторы представляют новую систему для развернутых ответов на вопросы в открытой предметной области, которая использует два последних достижения в области NLP: 1) современные модели разреженного внимания, такие как Routing Transformer (RT), которые позволяют масштабировать модели на основе внимания для больших последовательностей, и 2) модели извлечения релевантных текстов, такие как REALM, которые облегчают извлечение статей в Википедии, связанных с заданным вопросом. Прежде чем генерировать текст, данная система объединяет информацию из нескольких релевантных статей, тем самым способствуя порождению более фактологически обоснованных ответов. Система устанавливает новую планку на ELI5, единственном крупном общедоступном наборе данных для развернутых ответов на вопросы.

Однако, несмотря на то, что данная система возглавляет рейтинг лучших моделей, авторы обнаружили несколько тревожных тенденций в наборе данных ELI5 и связанных с ним оценочных метриках. В частности, было замечено, что:

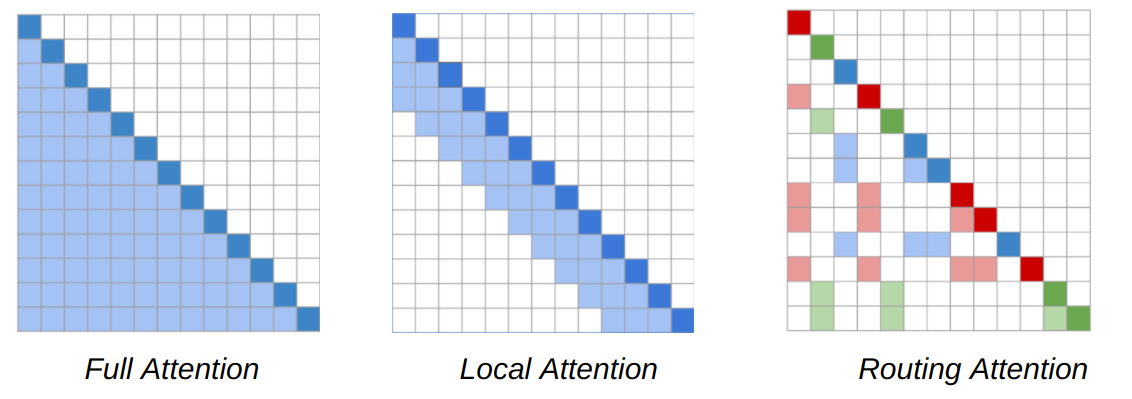

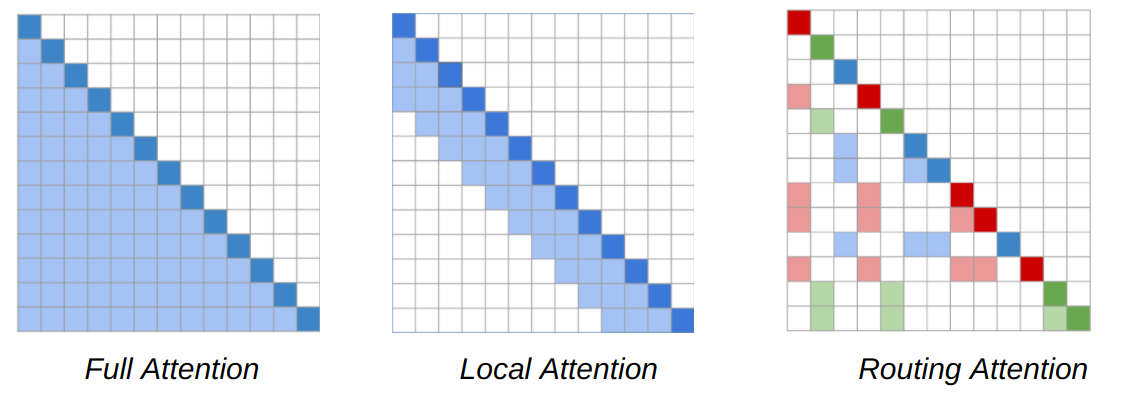

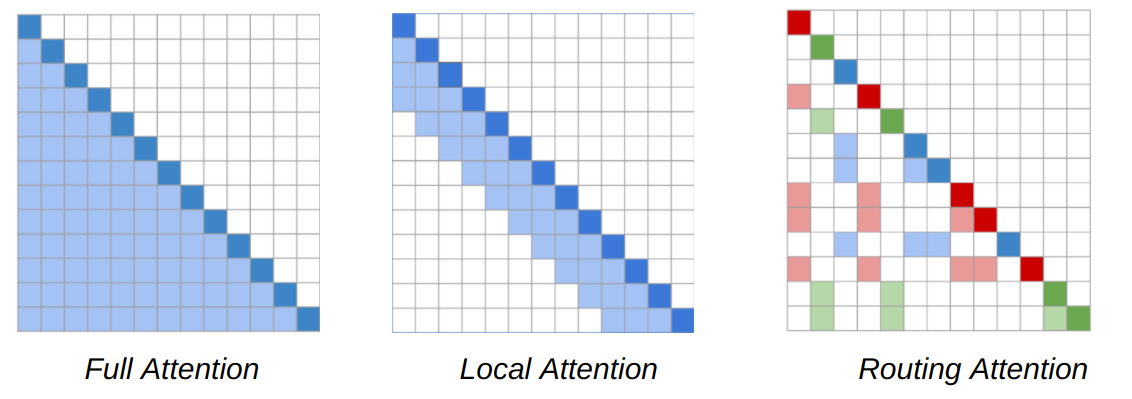

Ключевой вывод из работы по RT заключается в том, что такая связь всех токенов часто является избыточной и может быть приближена к комбинации локального и глобального внимания. Локальное внимание позволяет создать локальное представление каждого токена на нескольких уровнях модели, где он соотносится с локальным соседством, обеспечивая локальную согласованность и беглость. В дополнение к локальному вниманию, модель RT также использует мини-пакетную кластеризацию k-средних (k-means clustering), чтобы каждый токен мог соответствовать только набору наиболее подходящих токенов.

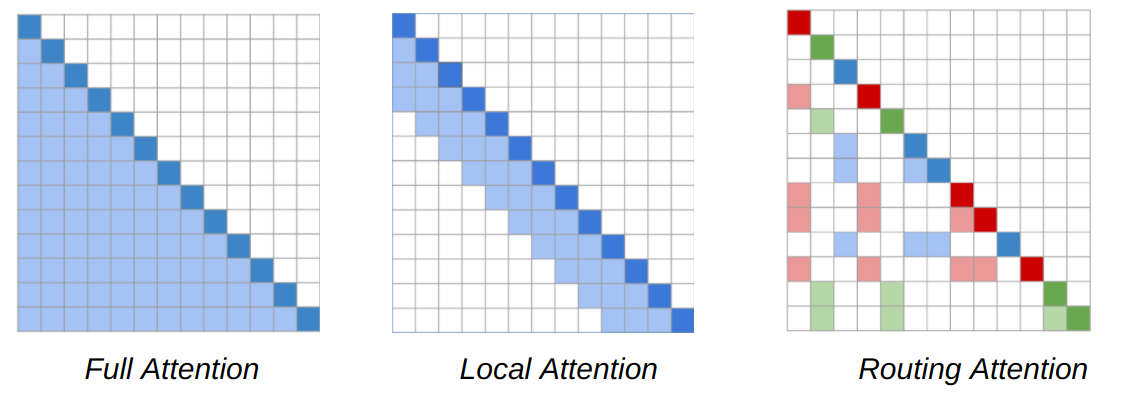

Карты внимания (attention maps) для основанного на содержимом механизма рассеянного внимания, используемого в Routing Transformer. Последовательность слов представлена диагональными квадратами темного цвета. В модели Трансформера (слева) каждый токен последовательности соотносится с каждым другим токеном. Более светлые квадраты представляют токены в последовательности, которой соответствует данный токен (темный квадрат). Модель RT использует как локальное внимание (в центре), где токены связаны только с другими токенами в своем локальном окружении, так и маршрутизирующее внимание (Routing Attention)(справа), в котором токен соотносится только с кластерами токенов, наиболее релевантных ему в контексте. Темно-красный, зеленый и синий токены относятся только к соответствующему цвету более светлых квадратов.

Авторы предварительно обучают RT-модель на наборе данных Project Gutenberg (PG-19) на задаче языкового моделирования, т.е. модель учится предсказывать следующее слово с учетом всех предыдущих слов, чтобы иметь возможность генерировать согласованный длинный текст.

Далее авторы улучшают качество извлечений REALM с помощью контрастивной функции потерь (contrastive loss). Идея состоит в том, чтобы стимулировать сближение векторного представления вопроса к представлению правильного ответа на него и удаление от других ответов в его мини-батче. Это позволяет достичь того, что при извлечении релевантных позиций с помощью векторного представления вопроса будут отбираться статьи, «схожие» с правильными ответами. Авторы называют такой модуль контрастивным-REALM или c-REALM.

Объединенная система RT + c-REALM для LFQA.

набора данных ELI5, который является частью теста KILT и единственным крупным общедоступным набором данных LFQA. Тест KILT измеряет извлечение текстов с помощью метрики Precision (R-Prec) и генерацию текста с помощью ROUGE-L. Объединив эти две метрики, авторы получают KILT R-L, которая определяет место модели в таблице лидеров. Авторы тонко настраивают предварительно обученную модель RT вместе с извлечениями из c-REALM на наборе данных ELI5 из KILT.

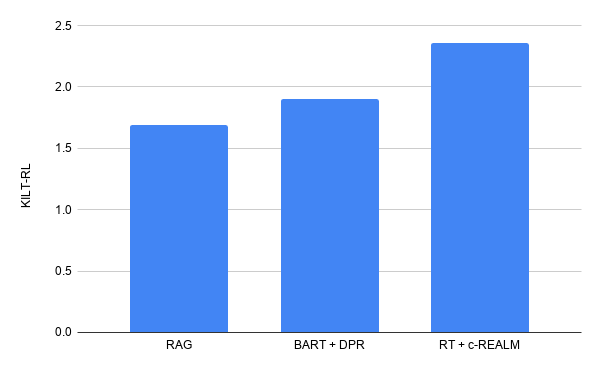

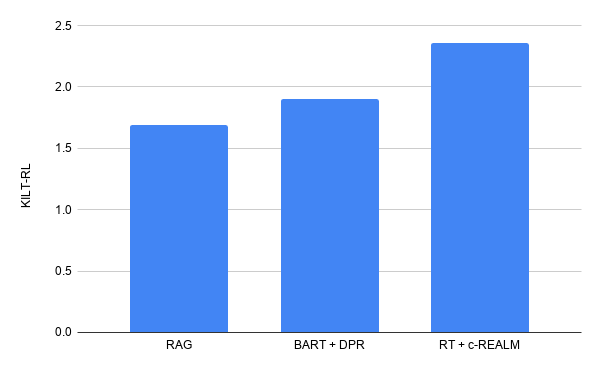

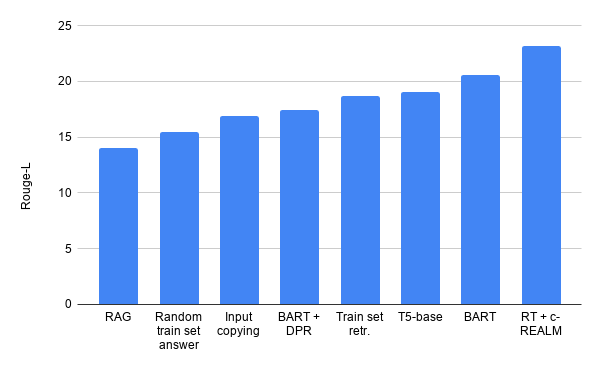

Результат авторов в таблице лидеров KILT для развернутых ответов на вопросы на ELI5 по объединенной метрике KILT R-L достигает 2.36. Этот результат превышает предыдущий результат на модели BART + DPR (KILT R-L равен 1.9), сохраняя схожее с другими моделями число параметров. В задаче генерации текста улучшение составляет +4.11, +5.78 и +9.14 по метрике Rouge-L для T5, BART + DPR и RAG соответственно.

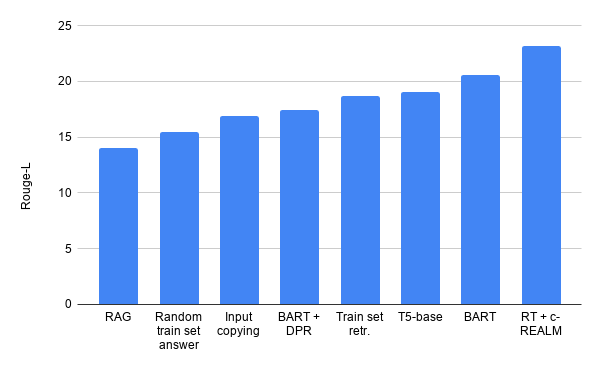

Результаты авторов в таблице лидеров KILT для развернутых ответов на вопросы на ELI5.

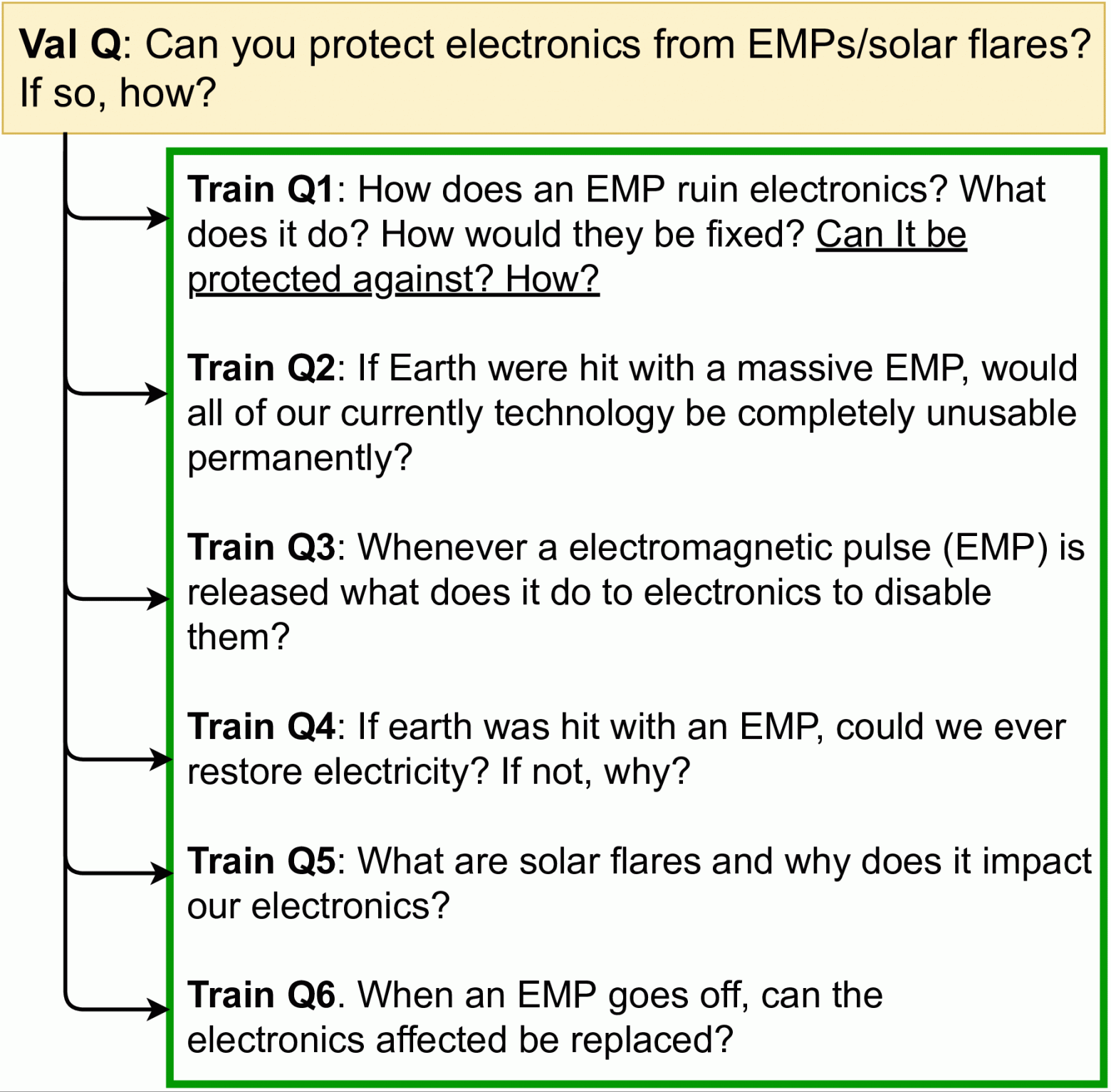

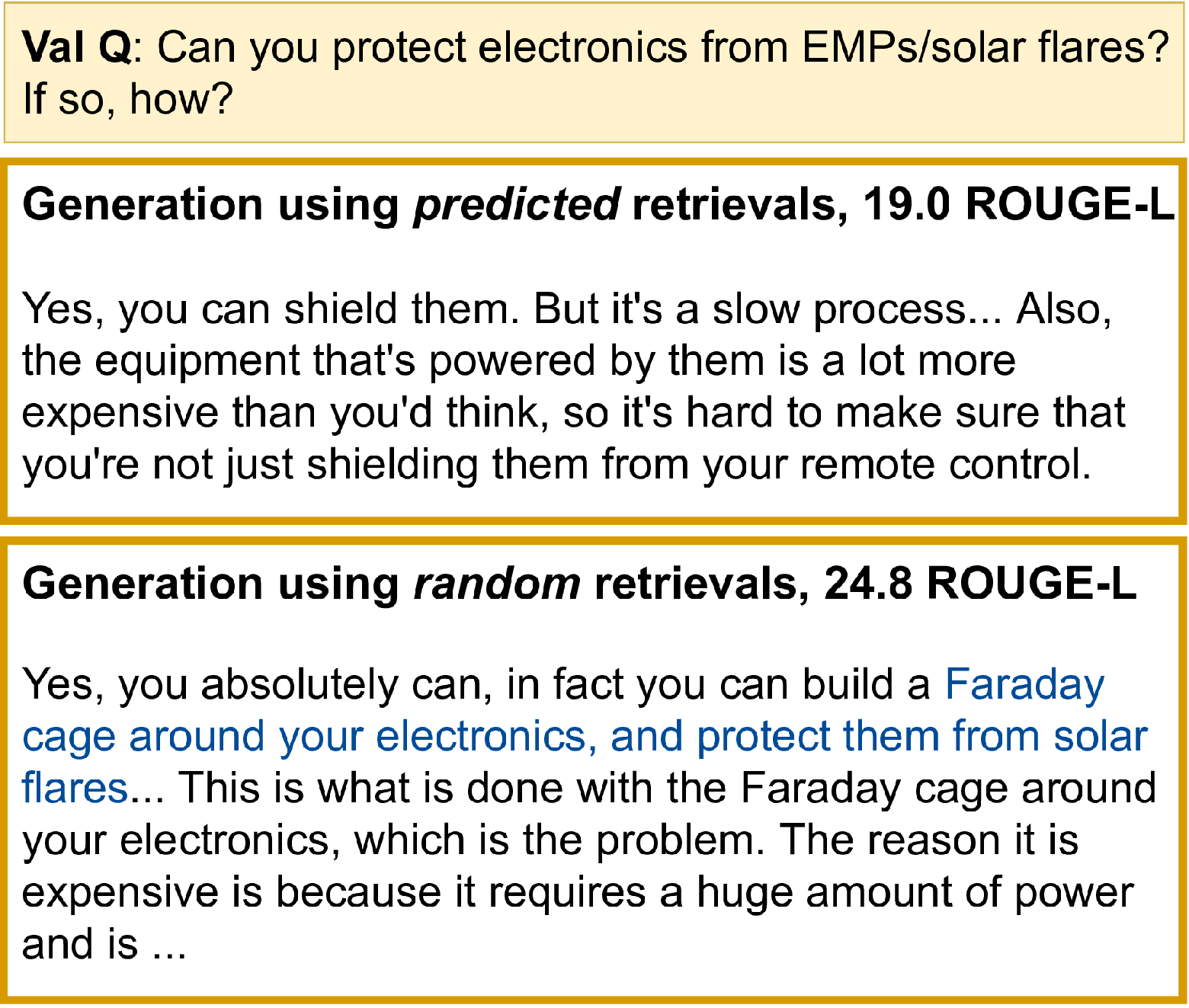

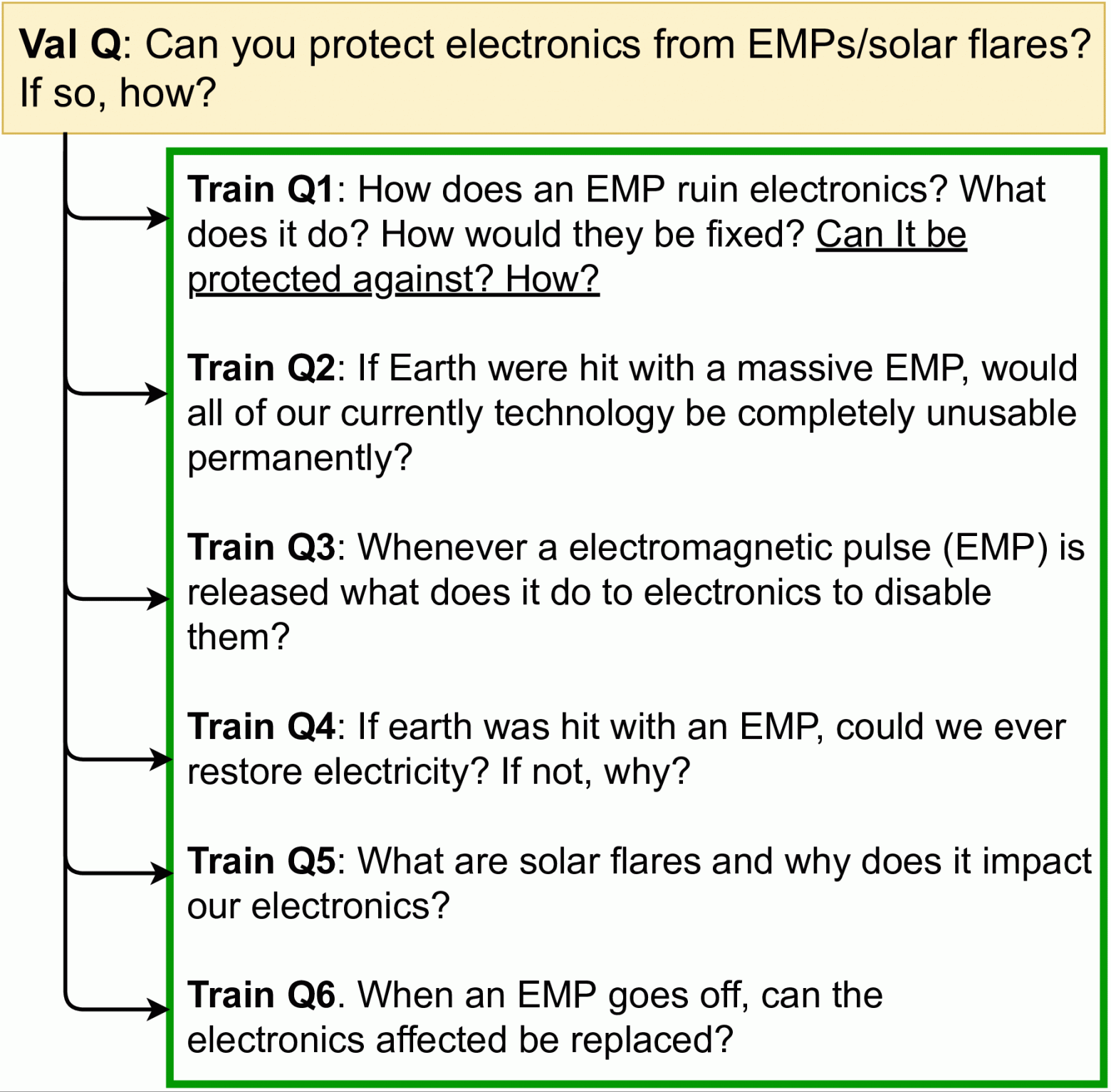

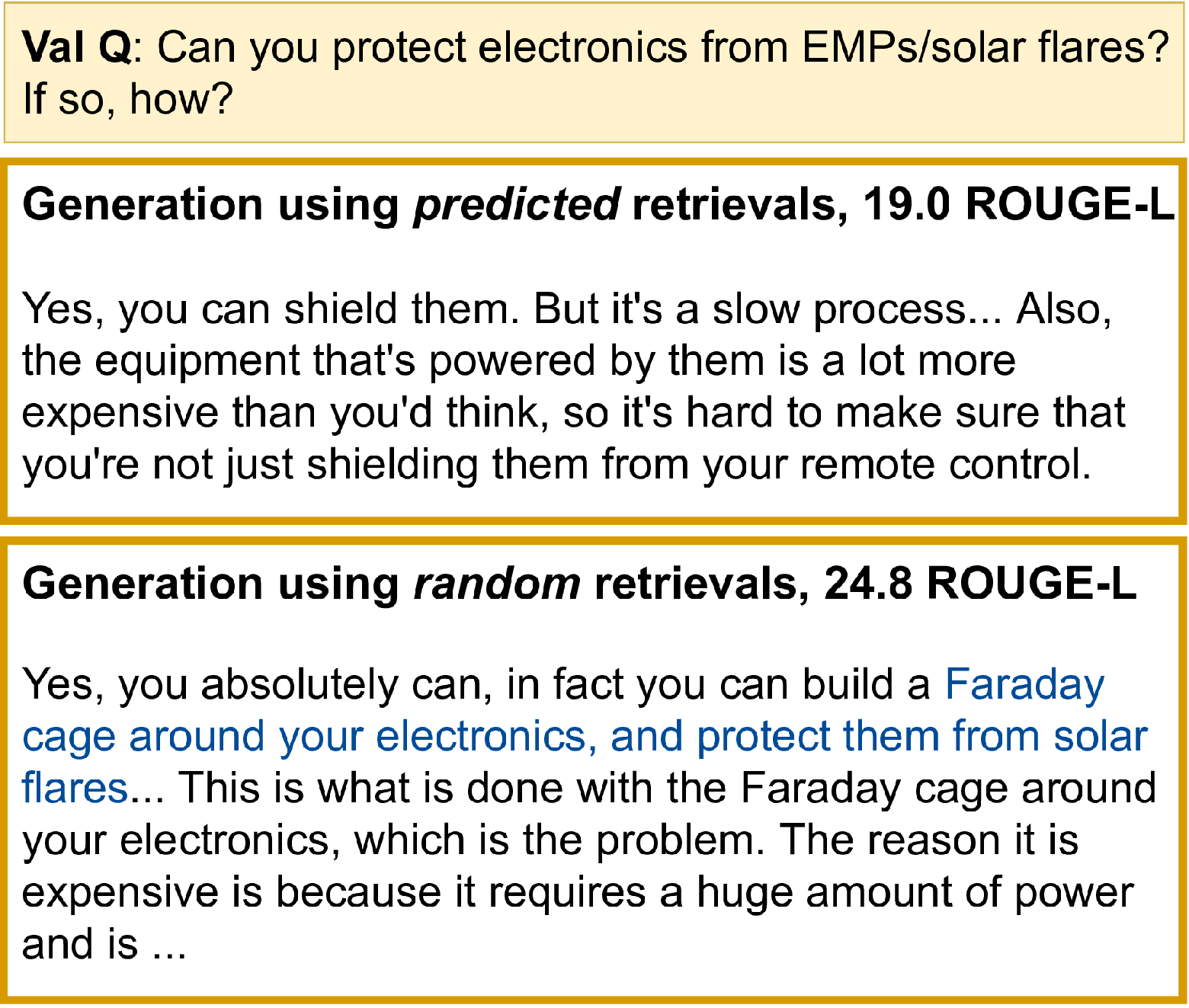

Авторы отмечают, что практически отсутствуют доказательства того, что модель фактически основывает свою генерацию текста на извлеченных документах — тонкая настройка модели RT со случайным извлечением из Википедии (т.е. случайное извлечение + RT) работает почти так же хорошо, как c-REALM + RT модель (24.2 против 24.4 ROUGE-L). Они также обнаружили значительное совпадение в наборах для обучения, валидации и тестирования ELI5 (при этом несколько вопросов являются перефразированием друг друга), что может устранить необходимость в поиске. Тест KILT измеряет качество извлечения и генерации отдельно, не проверяя, действительно ли генерация текста использует извлечения.

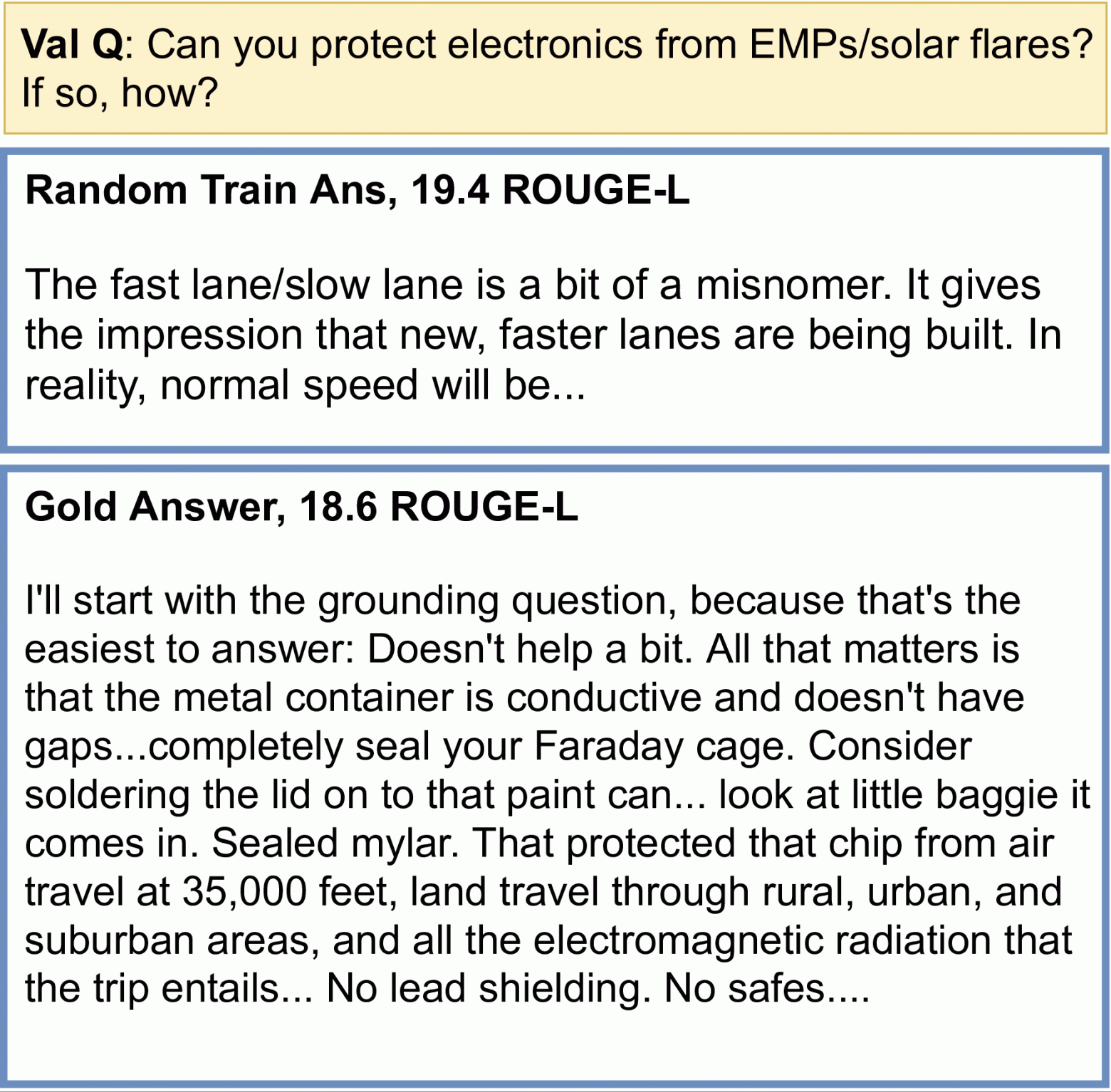

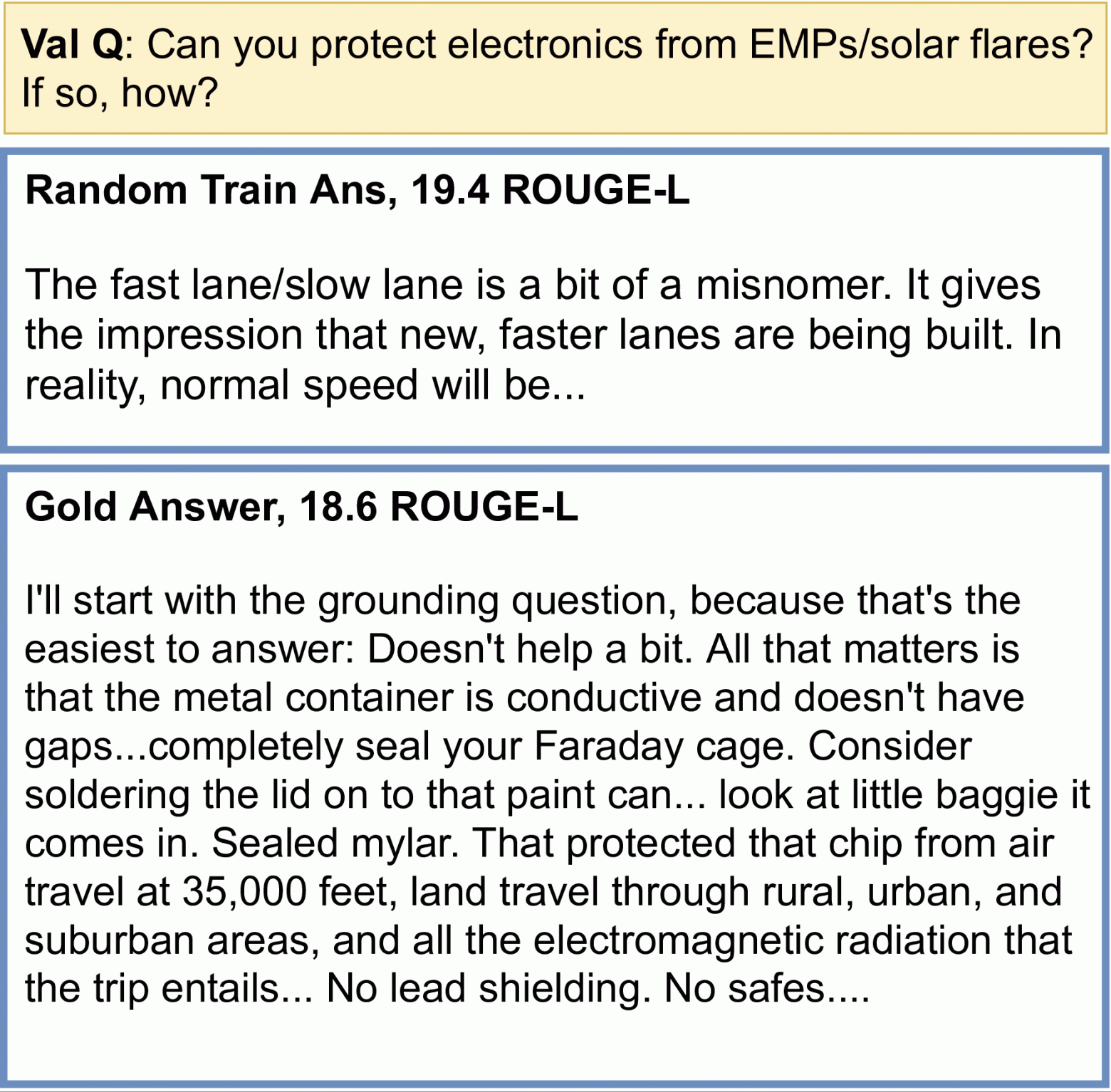

Тривиальные базовые модели получают более высокие баллы Rouge-L, чем RAG и BART + DPR.

Более того, авторы обнаружили проблемы с метрикой Rouge-L, используемой для оценки качества генерации текста, с тривиальными бессмысленными базовыми моделями, такими как Случайный ответ обучающего набора (Random Training Set answer) и Копирование входных данных (Input Copying), которые достигают относительно высоких оценок Rouge-L (даже превосходящих BART + DPR и RAG).

habr.com

habr.com

В статье «Hurdles to Progress in Long-form Question Answering» (появится на конференции NAACL 2021) авторы представляют новую систему для развернутых ответов на вопросы в открытой предметной области, которая использует два последних достижения в области NLP: 1) современные модели разреженного внимания, такие как Routing Transformer (RT), которые позволяют масштабировать модели на основе внимания для больших последовательностей, и 2) модели извлечения релевантных текстов, такие как REALM, которые облегчают извлечение статей в Википедии, связанных с заданным вопросом. Прежде чем генерировать текст, данная система объединяет информацию из нескольких релевантных статей, тем самым способствуя порождению более фактологически обоснованных ответов. Система устанавливает новую планку на ELI5, единственном крупном общедоступном наборе данных для развернутых ответов на вопросы.

Однако, несмотря на то, что данная система возглавляет рейтинг лучших моделей, авторы обнаружили несколько тревожных тенденций в наборе данных ELI5 и связанных с ним оценочных метриках. В частности, было замечено, что:

- существует мало свидетельств того, что модели действительно используют извлеченные тексты как основу для генерации;

- банальные базовые модели (например, копирование входа) превосходят современные системы, такие как RAG / BART+DPR;

- в наборе данных имеется значительное перекрытие между обучающей и валидационной подвыборками.

Генерация текста

Основной рабочей лошадкой моделей NLP является архитектура Трансформера, в которой каждый токен в последовательности соответствует каждому другому токену, в результате чего модель масштабируется квадратично длине последовательности. Модель RT представляет динамический, основанный на содержимом механизм разреженного внимания, который снижает сложность внимания в модели Трансформера с n2 до n1.5, где n — длина последовательности, что позволяет масштабировать ее до более длинных последовательностей. Благодаря этому каждое слово соотносится с другими релевантными словами в любом месте всего фрагмента текста, в отличие от таких методов, как Transformer-XL, где слово может соотноситься только со словами в непосредственной близости от него.Ключевой вывод из работы по RT заключается в том, что такая связь всех токенов часто является избыточной и может быть приближена к комбинации локального и глобального внимания. Локальное внимание позволяет создать локальное представление каждого токена на нескольких уровнях модели, где он соотносится с локальным соседством, обеспечивая локальную согласованность и беглость. В дополнение к локальному вниманию, модель RT также использует мини-пакетную кластеризацию k-средних (k-means clustering), чтобы каждый токен мог соответствовать только набору наиболее подходящих токенов.

Карты внимания (attention maps) для основанного на содержимом механизма рассеянного внимания, используемого в Routing Transformer. Последовательность слов представлена диагональными квадратами темного цвета. В модели Трансформера (слева) каждый токен последовательности соотносится с каждым другим токеном. Более светлые квадраты представляют токены в последовательности, которой соответствует данный токен (темный квадрат). Модель RT использует как локальное внимание (в центре), где токены связаны только с другими токенами в своем локальном окружении, так и маршрутизирующее внимание (Routing Attention)(справа), в котором токен соотносится только с кластерами токенов, наиболее релевантных ему в контексте. Темно-красный, зеленый и синий токены относятся только к соответствующему цвету более светлых квадратов.

Авторы предварительно обучают RT-модель на наборе данных Project Gutenberg (PG-19) на задаче языкового моделирования, т.е. модель учится предсказывать следующее слово с учетом всех предыдущих слов, чтобы иметь возможность генерировать согласованный длинный текст.

Извлечение информации

Чтобы продемонстрировать эффективность модели RT для задачи LFQA, авторы объединяют ее с извлеченными текстами из REALM. Модель REALM (Guu et al. 2020) — это модель, которая использует поиск на основе максимума скалярного произведения (maximum inner product search) для извлечения статей Википедии, относящихся к определенному запросу или вопросу. Модель была адаптирована для ответов на фактоидные вопросы на наборе данных Natural Questions. REALM использует модель BERT для получения хороших векторных представлений вопроса и использует SCANN для извлечения статей Википедии, которые имеют большое сходство по тематике с векторным представлением вопроса. Затем в ходе end-to-end обучения максимизируется log-likelihood на задаче QA.Далее авторы улучшают качество извлечений REALM с помощью контрастивной функции потерь (contrastive loss). Идея состоит в том, чтобы стимулировать сближение векторного представления вопроса к представлению правильного ответа на него и удаление от других ответов в его мини-батче. Это позволяет достичь того, что при извлечении релевантных позиций с помощью векторного представления вопроса будут отбираться статьи, «схожие» с правильными ответами. Авторы называют такой модуль контрастивным-REALM или c-REALM.

Объединенная система RT + c-REALM для LFQA.

Оценка

Авторы тестируют модель на развернутых ответах на вопросы с использованиемнабора данных ELI5, который является частью теста KILT и единственным крупным общедоступным набором данных LFQA. Тест KILT измеряет извлечение текстов с помощью метрики Precision (R-Prec) и генерацию текста с помощью ROUGE-L. Объединив эти две метрики, авторы получают KILT R-L, которая определяет место модели в таблице лидеров. Авторы тонко настраивают предварительно обученную модель RT вместе с извлечениями из c-REALM на наборе данных ELI5 из KILT.

Результат авторов в таблице лидеров KILT для развернутых ответов на вопросы на ELI5 по объединенной метрике KILT R-L достигает 2.36. Этот результат превышает предыдущий результат на модели BART + DPR (KILT R-L равен 1.9), сохраняя схожее с другими моделями число параметров. В задаче генерации текста улучшение составляет +4.11, +5.78 и +9.14 по метрике Rouge-L для T5, BART + DPR и RAG соответственно.

Результаты авторов в таблице лидеров KILT для развернутых ответов на вопросы на ELI5.

Примеры генерации текста моделью RT

- Q: Why are almost all boats white?

- Q: What causes the trail behind jets at high altitude?

- Q: How do shampoo and conditioner work?

- Q: When glancing at a clock, why does the first second after glancing at it sometimes feel longer than the rest?

- Q: Why do Britain and other English empire countries still bow to monarchs? What real purpose does the queen serve?

- Q: What exactly is fire, in detail? How can light and heat come from something we can't really touch?

- Q: What goes on in those tall tower buildings owned by major banks?

Препятствия на пути к прогрессу в LFQA

Несмотря на то что система RT, описанная в данной статье, возглавляет публичную таблицу лидеров, подробный анализ модели и набора данных ELI5 позволяет выявить некоторые тревожные тенденции.- Train/Valid Overlap

- Gaming ROUGE-L

- Lack of Grounding

Авторы отмечают, что практически отсутствуют доказательства того, что модель фактически основывает свою генерацию текста на извлеченных документах — тонкая настройка модели RT со случайным извлечением из Википедии (т.е. случайное извлечение + RT) работает почти так же хорошо, как c-REALM + RT модель (24.2 против 24.4 ROUGE-L). Они также обнаружили значительное совпадение в наборах для обучения, валидации и тестирования ELI5 (при этом несколько вопросов являются перефразированием друг друга), что может устранить необходимость в поиске. Тест KILT измеряет качество извлечения и генерации отдельно, не проверяя, действительно ли генерация текста использует извлечения.

Тривиальные базовые модели получают более высокие баллы Rouge-L, чем RAG и BART + DPR.

Более того, авторы обнаружили проблемы с метрикой Rouge-L, используемой для оценки качества генерации текста, с тривиальными бессмысленными базовыми моделями, такими как Случайный ответ обучающего набора (Random Training Set answer) и Копирование входных данных (Input Copying), которые достигают относительно высоких оценок Rouge-L (даже превосходящих BART + DPR и RAG).

Заключение

Авторы предложили систему развернутых ответов на вопросы на основе Routing Transformers и REALM, которая возглавляет таблицу лидеров KILT на ELI5. Однако подробный анализ выявляет несколько проблем с тестированием моделей, которые не позволяют использовать его для получения сведений о значимых достижениях в моделировании. Авторы выражают надежду, что сообщество будет работать вместе над решением этих проблем, и исследователи смогут покорить эту гору и добиться значимого прогресса в такой сложной, но важной задаче.Авторы

- Автор оригинала – Aurko Roy

- Перевод – Смирнова Екатерина

- Редактирование и вёрстка – Шкарин Сергей

Достижения и проблемы генерации развернутых ответов на вопросы открытой предметной области

Развернутые ответы на вопросы открытой предметной области (Open-domain Long-form Question Answering, LFQA) — это одна из фундаментальных задач в обработке естественного языка (Natural Language...